Liste de lois de probabilité

Toute fonction f(x), définie, intégrable et non négative sur un domaine A, peut servir de distribution de probabilité d'une variable aléatoire X prenant des valeurs dans le domaine A. Il faut et il suffit qu'elle soit multipliée par un facteur a qui assure que la « probabilité totale » — la somme ou l'intégrale des f(x) sur le domaine — soit égale à 1 (100 % de probabilité).

- Lorsque la fonction f(x|θ) dépend d'un paramètre, le facteur a(θ) est appelé fonction de partition.

- Une définition plus exacte et rigoureuse existe, valable également lorsque le domaine n'est pas simplement dénombrable ou continu.

Il y a donc une infinité de distributions possibles. Cependant, certaines sont plus courantes, plus utiles dans les applications pratiques ou plus importantes dans la théorie. Celles-ci ont en général reçu un nom particulier.

- Convention de terminologie et notations

- L'intersection du langage scientifique avec la langue vernaculaire a obscurci le sens rigoureux des termes « probabilité », « distribution » ou « loi ». En toute rigueur,

- Fonction de répartition : FX(x) signifie la probabilité P(X ≤ x).

- Fonction de probabilité : fX(k) ou pX(k) signifie la probabilité de masse discrète P(X=k).

- Fonction de densité fX(x) signifie la dérivée (continue) de la fonction de répartition.

- Distribution (de probabilité) signifie le modèle auquel répond la variable (discret ou continu ou autre, fonctions de répartition et de densité/probabilité, fonctions génératrices, etc.).

- Loi de probabilité est un terme utilisé en France à la place de « distribution ». À ne pas confondre avec l'usage anglais, où « law » signifie un modèle théorique, une affirmation, comme les lois de Kepler ou la loi de la thermodynamique. Par exemple, la loi de Zipf (Zipf's Law) énonce que les fréquences de mots d'un texte suivent la distribution de Zipf (Zipf Distribution).

On donne pour certaines distributions la forme fonctionnelle : il s'agit de la structure de dépendance de f(.) par rapport à la v.a., dépouillée de sa fonction de partition. Pour la formule complète, se référer à l'article correspondant. On a choisi d'utiliser k pour les valeurs d'une v.a. discrète et x pour une v.a. continue.

Distributions discrètes

Ces lois sont définies sur un support dénombrable, non continu (en général, des entiers). Le mot « discret » signifie « non continu ».

Domaine fini

- La loi uniforme discrète décrit un tirage aléatoire à n résultats possibles équiprobables : pile ou face, dé, roulette de casino, tirage d'une carte.

- La loi triangulaire discrète décrit la somme de deux uniformes indépendantes de même paramètre : résultat du jet de deux dés.

- La loi de Bernoulli décrit un tirage aléatoire à deux résultats possibles, de probabilités respectives p et 1-p. Des exemples courants : pile ou face (probabilité p=1/2), homme ou femme, produit valable ou défectueux, etc.

- La loi de Rademacher est une Bernoulli équiprobable (p=1/2) où le succès vaut 1 et l'échec −1.

- La loi de Markov-Pólya (à ne pas confondre avec la loi binomiale négative généralisée à un paramétrage non entier qui peut parfois aussi s'appeler loi de Pólya), qui compte de nombre de boules blanches tirées dans une urne contenant des boules blanches et noires après un certain nombre de tirages.

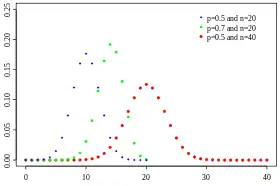

- La loi binomiale correspond à la loi de Markov-Pólya dans le cas de tirages avec remise simple (on remet la boule que l'on vient de piocher dans l'urne). Elle compte ainsi le nombre de succès d'une série de n tirages Bernoulli indépendants de probabilité de succès p connue.

- La loi Poisson binomiale décrit le résultat d'une série de tirages de Bernoulli indépendants dont la probabilité de succès p n'est pas constante.

- La loi hypergéometrique correspond à la loi de Markov-Pólya pour des tirages sans remise. Ainsi elle décrit le résultat d'une série de tirages de Bernoulli dépendants.

- La loi bêta-binomiale correspond à la loi de Markov-Pólya dans le cas de tirages avec remise double (on remet la boule que l'on vient de piocher dans l'urne à laquelle on ajoute une autre boule de la même couleur). Elle décrit également le résultat d'une série de tirages de Bernoulli indépendants de probabilité de succès p aléatoire de loi bêta. Plus précisément la loi bêta-binomiale est un mélange de lois Bernoulli-bêta.

- La loi binomiale correspond à la loi de Markov-Pólya dans le cas de tirages avec remise simple (on remet la boule que l'on vient de piocher dans l'urne). Elle compte ainsi le nombre de succès d'une série de n tirages Bernoulli indépendants de probabilité de succès p connue.

- Il existe des variantes (« généralisations ») de la loi hypergéométrique qui modifient la probabilité relative de tirage des boules :

- La loi de Zipf est une distribution puissance, appliquée à la distribution des tailles ou des fréquences en fonction du rang, par exemple dans le calcul des fréquences relatives de mots dans un texte, ou celui des tailles relatives des villes d'un pays.

- La loi de Zipf–Mandelbrot et la loi fractale parabolique généralisent la distribution de Zipf.

- La loi de Benford décrit la fréquence relative des chiffres initiaux d'un ensemble de nombres. Elle est utilisée pour identifier le caractère artificiel de certains ensembles de données (fraudes économiques ou scientifiques).

Domaine infini

- La loi géométrique décrit le nombre d'essais nécessaires, dans une suite de tirages de Bernoulli, avant d'obtenir un succès.

- La loi binomiale négative, ou loi de Pascal, généralise la loi géométrique pour l'obtention de n succès. On l'appelle parfois loi de Pólya lorsqu'elle est généralisée à un paramètre n non entier (à ne pas confondre avec la loi de Markov-Pólya).

- La loi binomiale négative étendue est la binomiale négative décalée (le domaine va de m à l'infini).

- La loi bêta-binomiale négative permet de rendre aléatoire la probabilité p de succès.

- La loi de Poisson décrit la probabilité d'observer un certain nombre d'événements aléatoires dans un intervalle continu (durée, longueur). Elle connaît une série de distributions dérivées :

- la loi de Poisson décalée pour x > m.

- la loi hyper-Poisson

- la loi de Conway-Maxwell-Poisson, une extension à deux paramètres de la loi de Poisson permettant un taux de survenance ajustable en fonction des événements déjà produits (files d'attente, grossesses).

- La loi de Skellam, distribution de la différence de deux variables de Poisson indépendantes.

- La loi de Delaporte est la convolution (la somme) d'une Poisson et d'une binomiale négative.

- La loi logarithmique est basée sur le développement en série de la fonction logarithme. Elle a été utilisée dans la description de populations d'espèces.

- La loi zêta, ou loi de Pareto discrète, basée sur la fonction zeta de Riemann, est la distribution de Zipf étendue à un nombre infini d'éléments. Elle a des applications en mécanique statistique et en théorie des nombres.

- La loi de Yule-Simon apparaît dans des modèles biologiques. Asymptotiquement elle ressemble à la loi de Zipf.

- La distribution de Boltzmann, importante en physique statistique, mesure les probabilités des niveaux d'énergie discrets d'un système en équilibre thermique. Elle connaît des cas particuliers :

- La distribution de Maxwell-Boltzmann quand il n'y a pas d'effets quantiques.

- La distribution de Bose-Einstein décrit la distribution des états d'énergie des bosons.

- La statistique de Fermi-Dirac décrit la distribution des états d'énergie des fermions.

Distributions continues

Sur un intervalle borné

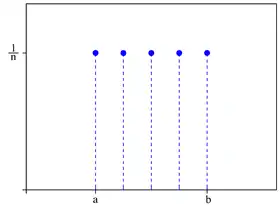

- La loi uniforme continue exprime l'équiprobabilité sur tous les points d'un intervalle fini [a,b].

- La loi rectangulaire est l'uniforme sur le domaine [-1/2, +1/2].

- La loi triangulaire continue est la distribution de la somme de deux variables uniformes (convolution de deux distributions uniformes).

- La loi de Irwin-Hall est la distribution de la somme de n variables uniformes [0,1] indépendantes.

- La loi Bates, selon les sources, est la distribution de la moyenne de n variables uniformes [0,1] indépendantes.

- La loi bêta est distribuée dans [0,1]. Elle sert par exemple à estimer les valeurs possibles d'une probabilité.

- La loi bêta peut s'adapter sur un intervalle quelconque [c, d].

- La loi arc sinus est un cas spécial de la loi bêta, sur [0,1] ou sur [c,d].

- La distribution PERT, en ingénierie, et le modèle de Balding–Nichols, en génétique, sont des Bêta avec des paramètres particuliers.

- La loi uniforme est un cas particulier de la loi bêta (a=b=0). La loi de Xenakis est aussi un cas particulier de loi Bêta.

- La loi power-beta est celle d'une puissance d'une loi bêta ; elle se situe entre une loi bêta et une loi Kumaraswamy.

- La loi Kumaraswamy est très proche de la loi bêta ; les formules de ses fonctions de densité et de répartition sont plus faciles à utiliser.

- La loi bêta généralisée a des cas particuliers parmi toutes les catégories décrites ici.

- La loi sub-bêta est la distribution de la fraction X⁄(X+Y) quand X et Y suivent des lois exponentielles indépendantes.

- La loi alpha est distribuée sur [0,1].

- La loi de Pearson Type II est une loi bêta symétrique autour de zéro. Elle a pour limite la loi normale.

- La loi du cosinus surélevé sur un intervalle [-s,+s]

- La loi réciproque

- La loi parabolique ou loi en U

- La loi puissance

- La loi logarithmique continue

- La loi du demi-cercle de Wigner, ou de Sato-Tate, ou loi elliptique, joue un rôle dans la théorie des matrices aléatoires (distribution des valeurs propres).

- La loi de Wigner est le cas limite de la loi de Kesten-McKay.

- La loi logit-normale, sur (0,1), est la distribution d'une variable dont la transformée logit est une v.a. normale.

- La normale peut bien sûr être tronquée sur un domaine fini [c, d].

- La loi de von Mises ou de Tikhonov ou loi normale circulaire établit la distribution d'angles ou de directions sur le cercle [0, 2π]. N.B.: cette loi peut être vue comme une distribution bivariée sur le cercle. Voir ci-dessous.

Sur un intervalle semi-fini

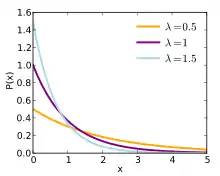

- La loi exponentielle mesure le temps d'attente avant la survenance d'un événement aléatoire dans un processus de Poisson (ou, alternativement, la durée entre deux événements consécutifs). C'est un cas particulier de la loi Gamma.

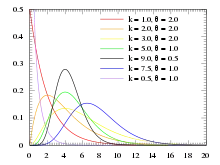

- La loi Gamma ou loi de Pearson Type III mesure le temps d'attente avant la survenance de N événements aléatoires dans un processus de Poisson. Elle généralise la loi exponentielle.

- La loi d'Erlang est un autre nom de la distribution Gamma lorsque le paramètre N est entier.

- La loi log-gamma est la distribution d'une variable dont le logarithme suit une distribution Gamma.

- La loi gamma généralisée a beaucoup de cas particuliers, selon l'exposant de x dans l'exponentielle.

- La loi inverse-gamma ou loi de Pearson Type V est la distribution d'une variable X dont l'inverse 1⁄X suit une distribution Gamma.

- La loi de Nakagami sert à modéliser la racine carrée d'une Gamma.

- La loi de Rayleigh sert, entre autres, à distribuer la distance à l'origine d'un point tiré d'une Normale bivariée centrée en (0,0).

- La loi de Rice est une généralisation de la loi de Rayleigh : distance d'une variable aléatoire normale bivariée à un point quelconque du plan.

- La loi de Wald, ou loi inverse-gaussienne, est la distribution du temps d'attente d'un mouvement brownien.

- La loi Ex-Wald, est la convolution (somme) d'une loi de Wald et d'une loi exponentielle.

- La loi de Lévy est distribuée sur [µ,∞[ . (Voir loi stable)

- La loi du χ² — prononcé « khi-carré » ou, parfois en France, « khi-deux » — est la distribution de la somme des carrés de n variables aléatoires Normales Standard indépendantes. Elle sert à décrire la distribution d'une variance d'échantillon. Elle a des applications dans les tests d'ajustement de données de comptage. C'est un cas particulier de la loi Gamma.

- La loi du χ² non centrée est la distribution de la somme des carrés de n variables aléatoires normales (µ,1) indépendantes.

- La loi inverse-χ² est la distribution d'une variable X dont l'inverse 1⁄X suit une distribution Khi-carré.

- La loi inverse-χ² recalibrée

- La loi du χ décrit la distribution de la racine carrée d'une khi-carrée, par exemple un écart-type d'échantillon.

- La loi du χ non centrée décrit la distribution de la racine carrée d'une khi-carrée non centrée.

- La loi bêta prime (β'), ou loi Bêta II ou loi de Pearson de type VI, est la distribution du ratio de deux v.a. exponentielles indépendantes.

- La loi bêta prime généralisée a pour cas particuliers la β', la Gamma composée, la loi de Dagum, la loi log-logistique, la loi de Burr.

- La loi gamma composée est la distribution d'une v.a. Gamma dont le paramètre (λ) est distribué selon une Gamma. C'est un cas particulier (p=1) de la Bêta prime généralisée.

- La loi log-logistique, ou distribution de Fisk, est la loi d'une variable aléatoire dont le logarithme est distribué selon une Loi logistique. Elle est utilisée pour modéliser des durées de vie, des débits de cours d'eau, des distributions de revenus.

- La loi de Burr, ou de Singh-Maddala, ou loi log-logistisque généralisée, est communément utilisée pour étudier les revenus des ménages.

- La loi de Dagum, ou Burr inverse, est la distribution de l'inverse d'une v.a. de distribution Burr. Il existe une loi de Dagum de type I à trois paramètres et une loi de Dagum de type II à quatre paramètres, qui ajoute un point de masse en zéro.

- La loi F ou loi de Fisher ou de Fisher-Snedecor est la distribution du ratio de deux variables suivant une loi khi-2 indépendantes normalisées (c.-à.-d. divisées par leur degré de liberté). Elle s'utilise pour effectuer des tests en régression multiple et en analyse de la variance (ANOVA). Le carré d'une variable T de Student est une variable F de paramètre (1,m).

- Le T² de Hotelling est la distribution d'une transformée de F, qui s'utilise pour effectuer des tests d'analyse de variance.

- La loi F non centrée généralise la loi F au ratio de deux v.a. khi-carrées non centrées indépendantes normalisées.

- La distribution du ratio de deux v.a. khi-carrées indépendantes non normalisées (c.-à.-d. non divisées par leur degré de liberté) est la loi bêta prime.

- Distributions dérivées de la normale

- La loi log-normale est la distribution d'une variable dont le logarithme suit une distribution Normale. D'après le théorème central limite, elle décrit des phénomènes aléatoires qui sont le produit de plusieurs variables positives indépendantes.

- La loi normale repliée est la distribution de la valeur absolue d'une v.a. normale.

- La loi demi-normale est un cas particulier de la loi normale repliée avec μ = 0.

- La loi normale généralisée de type II

- La loi de Pareto a des applications dans l'étude de la répartition des richesses, entre autres. Elle a quatre types.

- La Pareto (type I), ou « distribution puissance ».

- La Pareto type II.

- La loi de Lomax est un cas particulier de Pareto type II.

- La Pareto type III.

- La Pareto type IV.

- La loi de Feller-Pareto est une généralisation supplémentaire de la type IV, à 5 paramètres.

- La loi de Pareto généralisée a pour support [µ,∞[ si c > 0 et [µ,µ-b⁄c[ si c > 0. Elle se réduit à une exponentielle si c tend vers 0.

- Distributions d'extrema (voir GEV ou loi de Fisher-Tippett)

- La loi de Weibull ordinaire, ou de Rosin-Rammler, est la distribution d'un minimum. Elle décrit la durée de vie de composants techniques, ou la distribution des tailles des particules produites par des opérations de concassage. Elle a pour cas particuliers la loi exponentielle (a=1) et la loi de Rayleigh (a=2).

- La poly-Weibull est la distribution du minimum de plusieurs Weibull de paramètres différents.

- La Weibull exponentiée est une généralisation.

- La loi de Weibull renversée, ou loi de Fisher-Tippett de type III, est la distribution d'un maximum. Elle a pour domaine x<m.

- La loi de Fréchet, ou loi de Fisher-Tippett de type II, est aussi une distribution de maximum. Son domaine est x>0.

- La loi de Gumbel (de type 2) généralise la loi de Fréchet.

- La loi de Gompertz, une Gumbel renversée, décrit des extrema et des taux de mortalité.

- La loi de Gompertz avec dérive, décrit le maximum d'une loi exponentielle et d'une loi de Gumbel.

- La loi gamma-Gompertz est une mixture gamma de lois Gompertz.

- La loi Exponentielle-Logarithmique est la distribution du minimum d'un nombre N de variables exponentielles, où N a une distribution logarithmique.

- La loi de Birnbaum–Saunders, ou loi du temps d'usure, est construite à partir de la normale, appliquée à une transformation . Elle a des applications en contrôle de qualité et modélisation des durées de vie de systèmes mécaniques.

- La loi de Planck s'utilise en physique statistique.

- La loi de Davis la généralise en décalant son mode et a été utilisée pour modéliser des distributions de revenus.

- La loi log-Cauchy est la distribution d'une variable dont le logarithme suit une distribution de Cauchy.

- La loi log-Laplace est la distribution d'une variable dont le logarithme suit une distribution de Laplace.

- La loi de Mittag–Leffler est un cas particulier de loi géométrique stable ou loi géo-stable.

Sur la droite des réels

Lois qui portent le nom de leur forme fonctionnelle :

- La loi arctangente est un cas de la loi de Cauchy.

- La loi sécante hyperbolique

- La loi logistique

- La loi logistique généralisée

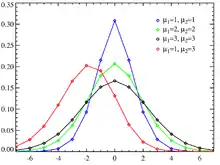

- La loi normale, ou courbe de Gauss ou courbe en cloche (« bell curve »), est extrêmement fréquente dans la nature comme dans les applications statistiques, du fait du théorème central limite : tout phénomène modélisable comme une somme de nombreuses variables indépendantes, de moyenne et variance finies, a une distribution asymptotiquement normale.

- La loi normale standard (ou centrée réduite) en est le cas le plus simple.

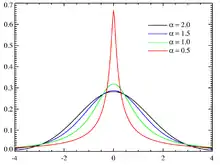

- La loi normale généralisée de type I, ou loi de puissance exponentielle ou loi d'erreur généralisée, a été utilisée pour modifier la forme de la normale, sans affecter la symétrie.

- La loi normale asymétrique introduit une asymétrie.

- La loi hyperbolique peut se définir comme une mixture de normales.

- La loi t ou loi de Student est utilisée dans de nombreux tests statistiques d'estimation de moyenne ou de régression linéaire. Une variable T de Student est le ratio d'une Normale standard et de la racine d'une Khi-carrée normalisée.

- La loi t non centrale est basée sur une Normale réduite non centrée.

- Il existe une loi t non standard : distributions de la variable µ + σt, où t est une Student, et une loi t discrétisée.

- La loi de Pearson Type IV est une version asymétrique de la Type VII.

- La loi de Pearson Type VII a pour cas particuliers la loi de Student, la loi normale (si a=1/m et m→infini) et la loi de Cauchy

- La loi z de Fisher est la distribution de la moitié du logarithme d'une v.a. Fisher. Elle est liée à la transformation de Fisher.

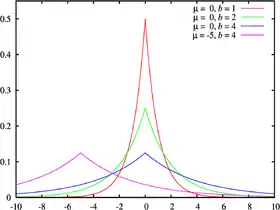

- La loi de Laplace a pour cas particulier, quand m=0, la Double Exponentielle, qui est la distribution de la différence de deux Exponentielles. C'est une loi stable.

- Distributions sans moments

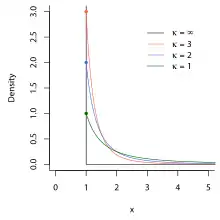

- La loi de Cauchy, ou de Breit-Wigner, est la distribution du ratio de deux normales centrées, autrement dit de la tangente de l'angle formé par ces deux Normales dans le plan. C'est un exemple de distribution sans espérance ni variance finies. En physique, elle porte le nom de fonction de Lorentz. C'est une loi stable.

- La loi de Voigt, ou profil de Voigt, est la convolution d'une Normale et d'une Cauchy. Elle trouve des applications en spectroscopie.

- La loi de Holtsmark est un exemple de distribution à espérance finie mais variance infinie. C'est une loi stable.

- La loi de Landau est aussi une loi stable. Les moments de la loi de Landau ne sont pas définis, en particulier la moyenne et la variance. Elle est utilisée en physique pour décrire les fluctuations des pertes d'énergie de particules chargées traversant une fine couche de matière.

- La loi de Linnik est une loi géométrique stable.

- Distributions d'extrema (voir GEV ou loi de Fisher-Tippett)

- La loi de Gumbel (de type 1), ou loi de Fisher-Tippett de type I, est aussi appelée log-Weibull, parce qu'elle est la distribution du logarithme d'une loi de Weibull. Elle est la distribution du maximum observé parmi plusieurs données.

- La loi de Gumbel standard en est le cas a=b=1, m=0.

Domaine variable

- La loi d'extremum généralisée, ou GEV (pour generalized extreme value) ou loi de Fisher-Tippett, a comme cas particuliers les distributions de Gumbel (ou type I) de domaine égal à l'ensemble des réels, de Fréchet (ou type II) de borne inférieure finie et de Weibull renversée (ou type III) de borne supérieure finie.

- La loi de Pareto généralisée peut être bornée inférieurement (k≤0) ou bornée des deux côtés (k>0).

- La loi de Tukey-Lambda a pour domaine la droite des réels ou un intervalle borné selon la valeur d'un de ses paramètres. Elle se définit par ses quantiles ; sa fonction de densité n'a pas de forme close.

Distributions mixtes discrète/continues

Ces distributions ont des points de masse parmi les valeurs continues. L'exemple le plus courant est celui du temps d'attente (à un feu de circulation, à un guichet) : il y a une probabilité que le temps soit égal à zéro s'il ne faut pas attendre (point de masse), puis une distribution continue s'il y a attente.

- La loi normale rectifiée remplace les valeurs négatives d'une loi normale par un point de masse en zéro.

- La loi de Dagum de type II ajoute un point de masse en zéro à la loi de Dagum de type I.

Distribution singulière

- La loi de Cantor a un domaine qui n'est ni discret, ni continu, mais fractal.

Distributions multivariées

Lorsque les variables aléatoires sont indépendantes, la fonction de densité de leur distribution conjointe est le produit des fonctions de densité individuelles.

Vecteur de variables aléatoires de domaines indépendants

- La loi de Dirichlet généralise la loi bêta.

- La loi normale multivariée généralise la loi normale.

- La loi multinomiale négative généralise la loi binomiale négative.

- La loi gamma généralisée multivariée (en)

Vecteur aléatoire de domaine contraint

Simplexe

- La loi multinomiale généralise la loi binomiale à plus de deux résultats possibles.

- La loi multihypergéométrique fait de même pour la loi hypergéométrique.

- La distribution catégorielle, ou multi-Bernoulli, n'est autre que la loi multinomiale lorsque le nombre de tirages N vaut 1. C'est une généralisation de la Bernoulli à une expérience présentant plus de deux résultats possibles. N.B. : elle est parfois présentée comme « distribution à support non numérique » ou « qualitatif », parce qu'elle dénombre la présence de tels critères, par exemple les nationalités dans un sondage.

- La distribution d'Ewens (en) est une distribution de probabilité sur l'ensemble des partitions d'un entier N, utilisée en génétique des populations.

Disque

- La distribution d'Airy est uniforme sur un disque.

Sphère

- La loi de Kent, ou de Fisher-Bingham, est une sorte de normale bivariée sur la sphère tridimensionnelle.

- La loi de von Mises-Fisher (en) généralise la loi de von Mises sur la sphère N-dimensionnelle.

Matrices aléatoires

- La loi de Wishart donne la distribution des matrices de variance-covariance d'échantillon.

- La loi de Wishart inverse donne la distribution des matrices inverses

- La loi normale matricielle et la loi t matricielle portent sur des échantillons de variables normales (resp. t) multivariées.

Familles

Certaines distributions ont des propriétés utiles qu'elles partagent avec d'autres. Parfois, ces « sœurs » peuvent être formulées comme des cas particuliers d'une expression générale.

- Pour une description plus précise de la notion de famille, voir famille exponentielle.

- La famille exponentielle est une (famille de) distributions dont la forme fonctionnelle est factorisable, de façon à générer une série d'avantages pour les applications en probabilité ou en analyse bayesienne. Elle comprend un très grand nombre des distributions décrites dans cet article. La sous-famille exponentielle naturelle exige une factorisation encore plus dépouillée. Elle comporte les lois binomiale, de Poisson, binomiale négative, Gamma, normale et une sixième sans nom propre. Elles ont pour propriété que la somme de deux variables indépendantes suit une loi de même forme (appelée la convolution).

- La loi stable, ou distribution de Lévy tronquée, est une famille de distributions continues dont la convolution est une distribution de la même forme ; elle a pour cas particuliers :

- La loi de Lévy (paramètres α=1/2 et β=1) sur le domaine [μ,∞[

- La loi normale (paramètre α=2)

- La loi de Laplace

- La loi de Cauchy (paramètre α=1)

- La loi de Landau (paramètres α=β=1)

- La loi de Holtsmark.

- La loi géométrique stable, ou géo-stable, est une famille de distributions telles que la somme d'un nombre N d'entre elles, où N a une distribution géométrique, a une distribution de la même forme ; elle a pour cas particuliers la loi de Linnik (cas symétrique, droite des réels), la loi de Laplace et la loi de Mittag-Leffler (sur [0,∞[).

- Les distributions de Pearson (12 types à l'origine) sont les différentes solutions d'une équation différentielle établie par Karl Pearson en 1894, afin d'obtenir des propriétés statistiques souhaitables. Plusieurs de ces solutions ont reçu un nom par la suite. On y retrouve notamment les distributions suivantes :

- Normale (cas-limite des types I, III, IV, V et VI)

- Bêta (type I) et Uniforme continue (cas-limite du type I)

- Gamma, Exponentielle et Khi-carrée (type III)

- Cauchy (type IV)

- Inverse-gamma (type V)

- Bêta prime (type VI)

- F (type VI)

- t de Student (type VII, et version symétrique du type IV)

- La famille de distributions logistiques généralisées (4 types) comprend, entre autres, la loi logistique asymétrique, la loi de Champernowne, la loi log-logistique décalée, la loi bêta généralisée et la loi de Burr.

Adaptations

- Les processus stochastiques et la distribution de phases (en) d'une chaîne de Markov.

- Les loi tronquées, ou conditionnelles, limitent le domaine de définition considéré (p.ex. une distribution normale sachant que x est positive).

- Les loi mélangées ou mixtures donnent la distribution globale d'une variable dans une 'population' dont chaque sous-groupe a sa propre loi (p.ex. la distribution des tailles dans une population mixte : bimodale).

Voir aussi

Articles connexes

- Relations entre distributions de probabilité

- Loi de probabilité

- Variable aléatoire

- Densité de probabilité

- Fonction de répartition

- Troncature

- Copule (mathématiques)

- Fonction de vraisemblance

- Portail des probabilités et de la statistique