Histoire de la connaissance du cerveau

Une histoire de la connaissance du cerveau montre que pendant des millénaires, le lieu même de la pensée et des émotions a fait débat. Il en est de même pour le lien entre le cerveau humain et les autres organes ou parties du corps, dans le fonctionnement normal comme en cas de maladies.

Antiquité

La conception antique de la fonction cérébrale se résume globalement en deux théories : le cardiocentrisme, théorie cardiocentriste d'Aristote pour lequel le cœur, organe chaud et sec, est le siège des facultés mentales ; le cérébrocentrisme ou céphalocentrisme, théorie céphalocentriste de Platon et plus tard de Galien pour lesquels ces facultés sont localisées dans le cerveau[1].

Aristote (coeur)

Pendant des millénaires, on croyait communément que l'activité mentale avait son siège au centre du corps humain, dans le cœur. Aristote défendait ce point de vue contre Hippocrate, par exemple, pour qui déjà pensées, sentiments et émotions étaient gouvernées par le cerveau. La vision d'Aristote, que nous savons aujourd'hui infondée, resta longtemps la plus couramment répandue (peut-être en raison des manifestations de tachycardie que l'on retrouve lors d'émotions intenses et qui contrastent avec l'absence de sensibilité absolue de l'organe cerveau) et se retrouve dans certaines expressions courantes : « Tu me brises le cœur », « Avoir un cœur de pierre », « Apprendre par cœur», etc.

Aristote ne voit ainsi dans le cerveau qu'une espèce de radiateur. Justifions cependant son erreur par quelques considérations anatomiques :

- le cerveau est effectivement un des organes les mieux vascularisés du corps humain ;

- mis à nu, le cerveau semble beaucoup moins sensible que le cœur aux stimulations mécaniques.

Cerveau

Il a fallu une véritable révolution philosophique et scientifique pour mener à l'idée du cerveau comme centre des pensées. Révolution philosophique avec Platon qui sépare l'âme en trois parties dont l'une, immortelle, se situe dans la tête. Mais aussi révolution scientifique dans la connaissance de l'anatomie humaine avec Hippocrate, Hérophile et Érasistrate. Les médecins acceptent ainsi peu à peu l'idée qu'un dégât au niveau du cerveau puisse avoir des conséquences au niveau d'autres organes. Cette connaissance scientifique reste cependant très limitée. Hippocrate écrit par exemple : « le cerveau est semblable à une glande... blanc, friable comme celle-ci ». Et Hérophile, bien qu'il participe grandement à l'accroissement de la connaissance de l'anatomie du cerveau, resta persuadé que toutes les affections du corps humain provenaient exclusivement de problèmes dus à des déséquilibres d' « humeurs ».

Après les travaux expérimentaux de Galien il n'était déjà plus possible de douter que le siège de l'«âme dirigeante» était dans le cerveau. Plus tard, d'autres personnes, comme Augustin d'Hippone (354-430), sans remettre en cause le caractère central du cerveau au détriment du cœur, place bien l'esprit au sein du cerveau mais au sein des espaces vides dont l'anatomie a révélé l'existence au sein du cerveau : les ventricules. Ces dernières structures ont été décrites dès le IIe siècle par Galien. Nemesius, au Ve siècle, attribue à chacun d'entre eux une fonction spécifique : l'imagination et les sensations à la partie antérieure, la réflexion à la partie médiane et la mémoire à la partie postérieure[2].

La vraie nature du cerveau et de ses relations avec les autres organes n'est donc pas encore comprise. Cependant la connaissance anatomique du cerveau a grandement progressé au cours de l'Antiquité.

Du XVIIe siècle à la première moitié du XIXe siècle

Il faudra attendre le XVIIe siècle en Europe pour dépasser le niveau de connaissance de l'Antiquité, grâce à l'essor des dissections à partir des XVIe-XVIIe siècles. Cependant ces siècles virent peu d'avancées significatives, bien qu'ils aient été riches en débats pour expliquer la spécificité de l'esprit humain et malgré le renouveau des études anatomiques à partir du XVIe siècle.

Descartes pensait que l'âme ne pouvait qu'être associée à une substance pensante (res cogitans) radicalement distincte de la matière qualifiée de substance étendue (res extensa). Au contraire, dans L'Homme-machine, en 1748, La Mettrie dénia la nécessité d'un recours à un pont entre esprit et matière (la glande pinéale selon Descartes): pour lui le corps doit être considéré comme une machine dans laquelle le cerveau est l'organe où se manifeste ce qu'on appelle l'âme.

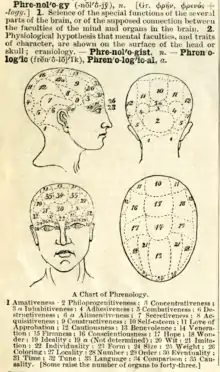

Les avancées suivantes eurent lieu au début du XIXe siècle avec les succès de la phrénologie, confirmant que le cerveau était le centre actif de toute connaissance et de toute émotion : au XVIIIe siècle, le neurologue François Joseph Gall émit une théorie, aujourd'hui dépassée, sur la localisation des fonctions cérébrales dans le cerveau (phrénologie). Puis dans la première moitié du XIXe siècle, François Broussais enseigna cette théorie, après avoir imaginé une théorie sur les relations entre « vie » et « stimulus » et sur l'interdépendance (ou « sympathies ») des divers organes. Ces théories eurent une influence sur Auguste Comte, qui publia un tableau cérébral dans son système de politique positive (1851).

Les recherches sur les localisations cérébrales opposèrent les partisans de la phrénologie (Gall, Broussais) à ceux d'une vision unitaire de l'activité du cerveau (Flourens). Entachée de thèses parfois fantaisistes (« la bosse des mathématiques » par exemple) la phrénologie inspira néanmoins les premières localisations de certaines fonctions au niveau du cortex et, en premier lieu, les recherches de Broca sur les aires cérébrales responsables du langage. Selon Gall, le cerveau est une collection de 27 aires correspondant à des activités mentales telles que la couleur, le son, le langage, l'honneur, l'amitié, l'art, la philosophie, le vol, le meurtre, l'humilité, la fierté et la socialisation.

Au tournant du XXe siècle

Dès la fin du XIXe siècle, presque tous les développements de la révolution scientifique avaient donné lieu à application dans l'étude du système nerveux central. Les progrès de l'électromagnétisme, de la chimie organique, de la microscopie... offrirent de nouveaux instruments à l'étude du cerveau et permirent de renouveler les méthodes de recherche reposant jusqu'alors sur la seule anatomie descriptive.

Une étape cruciale fut franchie avec la mise en évidence des cellules du système nerveux (que l'on appellera neurones) par Golgi et Cajal, grâce à une nouvelle technique de coloration qui permit également les études successives sur la forme, les propriétés, les fonctions et les connexions des neurones : Sherrington décrit le fonctionnement des systèmes réflexes, Sperry montre que les parties droite et gauche du cerveau sont impliquées différemment dans ses fonctions et Penfield établit une carte des localisations de la sensibilité somatique dans le cortex cérébral.

Au début du XXe siècle, il apparut bien vite qu'il y avait encore beaucoup à apprendre sur la manière dont le cerveau supervise le langage, faculté spécifique à l'être humain. Dès 1906, Sherrington (prix Nobel en 1932) décrivait le mécanisme corps-cerveau comme un mécanisme complexe, contrôlé par des boucles rétroactives. La rétroaction, écrivait Sherrington, permet au cerveau d'évaluer la nature de toute une gamme de stimuli et de produire la réponse appropriée. Dans le même temps, Santiago Ramon y Cajal étudiait la structure cellulaire du cerveau. Il découvrit que les cellules nerveuses, baptisées « neurones » par Waldeyer, constituent les unités fonctionnelles de base du système nerveux et transmettent l'influx nerveux sans jamais se toucher. Cette découverte lui permit d'élaborer la théorie du neurone en 1891. On démontra plus tard que l'influx nerveux passe d'un neurone à l'autre en traversant la synapse à l'aide de neurotransmetteurs.

De 1930 à 1950, le canadien Wilder Penfield fit considérablement évoluer les connaissances sur les localisations cérébrales. Il réalisa des stimulations électriques directes du cortex (au cours d'interventions chirurgicales) et répertoria méticuleusement les réponses aux stimuli. Il résuma ses expériences sous forme d'homonculus moteur et sensoriel.

Au tournant du XXIe siècle

Le XXe siècle voit les neurosciences induire une progressive naturalisation des objets de la philosophie de l'esprit (perception, langage, émotions, intelligence). Ainsi, l'approche neurophysiologique obtint des résultats remarquables dans l'étude du rêve (Jouvet) et des structures qui en sont responsables. À partir de cette jonction se constitue le champ des sciences cognitives qui feront bientôt appel également aux modèles mathématiques et cybernétiques, tout en prenant en compte le rôle essentiel des émotions (Damasio)[3] et de l'environnement (théories de la sélection neuronale de Changeux; darwinisme neuronal d'Edelman).

Renforcées par des techniques expérimentales toujours plus puissantes (microélectrodes, électroencéphalographies, radiographie X, caméra à positons et IRM) et enrichies d'un faisceau de disciplines complémentaires (neurobiologie, neuropsychologie, physico-chimie, génétique, embryologie...) les neurosciences abordent maintenant la description de ce qui fait la conscience de soi et la connexion entre conscient et inconscient.

Depuis son origine, la recherche sur le cerveau a connu principalement trois phases : phase philosophique, phase expérimentale et phase théorique. La prochaine phase a été annoncée comme une phase de simulation ― le futur des neurosciences[4].

Évolution des représentations du cerveau dans la seconde moitié du XXe siècle

Ce qui suit rend compte des thèses du Prof. Dr. Michael Hagner présentées à Goettingue, le lors d'une conférence intitulée "Ikonophilie und Ikonophobie in der Hirnforschung"

En faisant une étude des illustrations des livres scientifiques sur le cerveau, on constate une forte évolution au cours de la seconde moitié du XXe siècle. On pourrait dire que les scientifiques travaillant sur le cerveau sont passés d'une « iconophobie » à une « iconophilie ».

Iconophobie de la cybernétique

Après la Seconde Guerre mondiale, la cybernétique a été le paradigme dominant pour l'étude du cerveau.

On a considéré que le cerveau était équivalent à une machine à calculer. On était au début de l'émergence de l'informatique, et beaucoup de travaux théoriques s'accumulaient pour montrer comment, avec des opérations logiques basiques, on pouvait résoudre des problèmes complexes. Par analogie on a considéré que, n'importe comment, le cerveau réalisait des opérations logiques du même type que celle que l'on était en train de mettre au point pour les ordinateurs. La recherche sur le cerveau va alors se contenter de représenter les circuits logiques supposés être sous-jacents au fonctionnement du cerveau. Les représentations anatomiques sont absentes, ou bien simplifiées. Par exemple le célèbre livre de John von Neumann, « The computer and the brain », a pour illustration en page de garde un ordinateur occupant la majeure partie de la photo et John von Neumann posant sur le côté. Ou bien des schémas de neurones connectés ressemblent plus à des schémas de logique ou d'électronique qu'à des planches histologiques. De manière générale en biologie, deux types de représentation s'opposent, d'une part des représentations physionomiques, et d'autre part des représentations fonctionnelles. La cybernétique des années 1940 a choisi délibérément le deuxième. À l'instar du comportementalisme, il s'agit plus de savoir ce que fait le système plutôt que de savoir ce qu'est le système.

On peut tracer un parallèle entre cette abstraction systématique dans la représentation du cerveau de la part de l'école cybernétique des années 1940-50 avec le rejet général d'une approche particulariste dans la plupart des sciences de cette époque. En ethnologie par exemple domine le structuralisme avec notamment Claude Lévi-Strauss. En effet la représentation physionomique a été (trop) utilisée par les sciences sous influence nationaliste afin de mettre en exergue la supériorité de tel ou tel. Par l'abstraction systématique on veut au contraire refuser toute hiérarchisation, non seulement entre cultures humaines, mais aussi entre êtres vivants, voire entre toutes structures capables de traitement logique de l'information.

Iconophilie de l'imagerie cérébrale

Depuis les années 1990 on assiste plutôt à un retour de l'autorité de l'image comme élément de preuve scientifique dans le cadre de la recherche sur le cerveau. Bien que les nouvelles méthodes d'imagerie cérébrale nécessitent une haute technicité et un traitement informatique complexe, et que donc les images obtenues ne correspondent pas à une observation directe des phénomènes, elles exercent néanmoins par leur apparente simplicité, et par leur attractivité (de jolie couleur, parfois même des animations...), une fascination, une force de conviction intrinsèque. Consécutivement la comparaison ordinateur/cerveau perd de sa force dans la communauté des chercheurs en neuroscience. Elle est remplacée par les concepts d'auto-organisation, de plasticité, d'apprentissage… Ironiquement, la recherche en informatique tente même de faire des ordinateurs qui miment le cerveau. On parle de réseaux neuronaux, d'intelligence artificielle, d'ordinateur capable d'apprendre, ou tout simplement de « convivialité » des logiciels et des systèmes d'exploitation...

Néanmoins les spécialistes en neuroscience restent vigilants face à cette iconophilie. De plus en plus de critiques s'élèvent contre une « imagerie fonctionnelle » qui montre ce qui se passe pendant tel ou tel comportement/pensée, mais ne dit rien du comment est corrélé un comportement avec l'activation de telle ou telle aire cérébrale.

Une rumeur concernant le cerveau

On découvrit dans l'entre-deux guerres que le cerveau était composé de plus de cellules gliales que de neurones, dans un rapport qui fut estimé alors de 4 à 1. Il n'en fallut pas plus pour que des journaux titrent: « Nous n'utilisons que 20 % de notre cerveau pour penser », qui devint rapidement par déformations successives : « Nous n'utilisons notre cerveau qu'à 20 % de sa capacité ». Cette erreur perdure encore dans plusieurs milieux aujourd'hui[5] et constitue un neuromythe biaisant ainsi certaines réalités de l'éducation[6].

Notes et références

- Jean-Pierre Changeux, L'Homme neuronal, Hachette Littérature, , p. 18.

- Van der Eijk P, Nemesius of Emesa and early brain mapping, Lancet, 2008,372:440-441

- Antonio R. Damasio, L'erreur de Descartes : la raison des émotions, Odile Jacob, (ISBN 2-7381-0303-0)

- (en) Xue Fan et Henry Markram, « A Brief History of Simulation Neuroscience », Frontiers in Neuroinformatics, vol. 13, (ISSN 1662-5196, DOI 10.3389/fninf.2019.00032, lire en ligne, consulté le )

- Sophie Fleury, Vrai ou faux? On n'utilise que 20 % de notre cerveau, L'Internaute, 2007.

- « Méfiez-vous des neuromythes! », sur www.associationneuroeducation.org, .

Voir aussi

Bibliographie

- Matthew Cobb (trad. de l'anglais par Nicolas Chevassus-au-Louis, préf. Michel Morange), Une brève histoire du cerveau : de l'âme au neurone, Malakoff, Dunod, , 439 p. (ISBN 978-2-10-081707-8).

- Céline Cherici et Jean-Claude Dupont, Les querelles du cerveau : comment furent inventées les neurosciences, Paris, Vuibert, (ISBN 9782711770687).

- Jean-Didier Vincent, Voyage extraordinaire au centre du cerveau, Paris, Odile Jacob, , 455 p. (ISBN 978-2-7381-2349-7, lire en ligne)

- (en) Albright TD, Jessell TM, Kandel ER et Posner MI, « Neural science: a century of progress and the mysteries that remain », Neuron, vol. 25, , Suppl:S1-55 (PMID 10718192, DOI 10.1016/s0896-6273(00)80912-5, lire en ligne, consulté le ).

Articles connexes

Lien externe

- Club d'histoire des neurosciences sur le site de la bibliothèque interuniversitaire de médecine.

- Portail des neurosciences

- Portail de la médecine

- Portail de la psychologie

- Portail de l’histoire des sciences