Théorie de la décision dans l'incertain

La théorie de la décision dans l'incertain est l'une des principales branches de la théorie de la décision, à l'instar de la théorie des jeux, de la théorie de la décision multicritère, de la théorie de la décision multi-attributs et de la théorie de la décision collective. La décision dans l'incertain traite des situations de choix où le décideur est amené à prendre des décisions dans un environnement incertain (i.e., les conséquences des décisions ne sont pas connues avec certitude).

Incertitude

L'incertain se rencontre dans de nombreuses situations de la vie courante, ou encore dans de nombreuses problématiques scientifiques (mécanique quantique, économie, médecine, informatique...). L'incertain provient notamment de tous les événements que nous ne sommes pas capables de prédire avec certitude. Un exemple classique d'événement incertain est la météo. De nombreux débats existent dans la littérature scientifique sur l'existence réelle de l'incertain. Par exemple, en physique, les concepts de déterminisme basés sur les modèles Newtoniens, très à la mode aux XVIIIe et XIXe siècles, maintiennent que tout peut être prédit avec certitude. Néanmoins, les physiciens en mécanique quantique ont mis en évidence que la théorie Newtonienne ne s'appliquait plus dans leur cadre. Heisenberg ajoute même que les événements qui se réalisent au niveau subatomique surviennent de façon complètement incertaine. Sans s'étendre sur l'existence réelle ou non de l'incertain et sa nature, nous adoptons ici le point de vue des économistes, qui diffère du point de vue des physiciens ou des philosophes. En économie, est considéré comme faisant partie de l'incertain tout ce qui relève de l'ignorance de l'Homme. Par exemple il est tout à fait possible, en théorie, de prédire le résultat d'un jet de dé si nous disposons de tous les facteurs auxquels il est soumis. Mais à l'échelle humaine, l'ignorance de ces facteurs ainsi que la complexité des calculs à mettre en œuvre, font que le résultat a priori du jet de dé est indéterminé.

Dans la théorie des probabilités, une épreuve aléatoire est un phénomène pour lequel toutes les issues possibles sont connues, mais dont on ignore celle qui se réalisera vraiment. L'ensemble des états de la nature correspond à l'ensemble des issues possibles d'une épreuve aléatoire. On appelle événement toute proposition logique qui peut être vérifiée ou non à l'issue de la réalisation d'une épreuve aléatoire. Un événement est représentable de manière unique par un sous-ensemble de . L'événement est réalisé si l'état de la nature qui se réalise appartient à . Un événement élémentaire est un événement composé d'un seul élément .

Problème de décision sous incertitude

Dans un problème de décision sous incertitude, les événements conduisent à différentes conséquences. Le décideur est alors amené à réaliser un choix entre plusieurs épreuves aléatoires menant à différents ensembles de conséquences. Ces épreuves aléatoires sont appelées loteries. Une loterie est un ensemble d'événements disjoints associés à des conséquences dont l'union de ces événements donne l'événement certain . Plus formellement, si est un ensemble fini de conséquences réelles, on note la loterie qui associe la conséquence à chaque événement pour tout avec et pour tout .

On définit la relation de préférence sur les loteries qui se lit est préféré à. La partie symétrique et la partie asymétrique se lisent respectivement est indifférente à et est strictement préférée à. Dans l'optique de comparer les différentes loteries d'un problème de décision, la théorie de la décision dans l'incertain propose d'utiliser une fonction d'évaluation (ou fonction de valeur ou encore fonction représentative des préférences) pour décrire les préférences du décideurs entre les loteries (i.e., pour toutes loteries et .

Exemple 1 - Situation de décision sous incertitude

Un décideur peut choisir d'assurer sa voiture contre le vol pour un an (décision ) ou pas (décision ). Au cours de cette année il peut soit se faire voler sa voiture (événement ) soit pas (événement ). De plus nous savons que la voiture a une valeur de 100 000 € et que l'assurance contre le vol coûte 5 000 €. Dans cet exemple le décideur est soumis au choix entre deux loteries, la loterie qui découle de la décision et la loterie qui découle de la décision . Le tableau ci-dessous illustre la situation de choix soumis au décideur. Si le décideur choisit de s'assurer alors .

| -5 000 € | -5000€ | |

| -100 000 € | 0 € |

Raisonner sous incertitude[1],[2],[3],[4],[5],[6],[7],[8]

Pour raisonner dans l'incertain, il est nécessaire de prendre en compte le type de donnée dont on dispose. En 1921, Frank Knight distingue le risque et l'incertitude. Il définit par le terme de risque toutes les situations pour lesquelles il existe une distribution de probabilité connue du décideur, sur l'ensemble des états de la nature, et par le terme d'incertitude toutes les autres situations. Depuis la littérature scientifique propose plusieurs formalismes pour discriminer les cas d'incertitude. Les plus connues sont:

- Le risque : lorsque l'incertitude est représentée par une distribution de probabilité sur les événements.

- L'incertitude totale : lorsque l'on ne possède aucune information sur la vraisemblance des événements.

- Le risque imprécis : lorsque l'incertitude est représentée par une distribution de probabilité intervalle sur les événements élémentaires.

- Incertitude représenté par un ensemble de mesures de probabilités.

- Incertitude représentée par des fonctions de croyances.

- Incertitude représentée par des mesures de possibilités.

- Incertitude représentée par une relation d'ordre sur la vraisemblance des événements.

Théorie de la décision dans le risque

Lorsque le décideur connaît la distribution de probabilité s'appliquant sur l'ensemble des états de la nature, on dit que l'on est dans un problème de décision dans le risque. Dans le cadre du risque, on appelle loterie toute distribution de probabilité sur un ensemble fini de conséquences réelles. Si est un ensemble fini de conséquences réelles, on note alors la loterie qui associe la probabilité à la conséquence telle que . Dans un problème de décision dans le risque, le décideur cherche alors à classer par ordre de préférence les loteries qui lui sont proposées afin de sélectionner celle qu'il préfère. Pour cela on utilise un fonction d'évaluation de loterie qui associe à chaque loterie une valeur réelle. La recherche d'une fonction d'évaluation de loterie permettant de décrire finement les préférences d'un décideur est un problème qui a fait couler beaucoup d'encre dans la littérature.

Espérance de gain et paradoxe de Saint-Petersbourg

Au XVIIe siècle, au moment où se développe la théorie moderne des probabilités, des mathématiciens comme Pascal et De Fermat font l'hypothèse que l'évaluation d'une loterie se fait via un calcul de son espérance de gain :

Cependant, il est intéressant de remarquer qu'un décideur qui prend ses décisions en fonction de l'espérance de gain peut parfois prendre des décisions étonnantes, comme le montre le paradoxe de Saint-Pétersbourg proposé initialement par Nicholas Bernoulli dans une lettre en 1713. Ce paradoxe a ensuite été repris et modifié par Daniel Bernoulli, son neveu, et a été discuté dans les Transactions de l'Académie de Saint-Pétersbourg, d'où son nom. Le principe du jeu de Saint-Pétersbourg est le suivant : on lance en l'air une pièce de monnaie. Si Face apparaît, la banque paie 2 € au joueur, et on arrête le jeu. Sinon, on relance la pièce. Si Face apparaît, la banque paie 4 € au joueur, et on arrête le jeu. Sinon, on relance la pièce. Si Face apparaît, la banque paie 8 € au joueur, et ainsi de suite. Autrement dit, si Face apparaît pour la première fois au -ième lancer, la banque paie € au joueur.

On propose maintenant au décideur de déterminer la somme qu'il serait prêt à miser pour jouer à ce jeu. Le décideur détermine alors la mise pour laquelle le jeu est équitable (au sens de l'espérance de gain), c'est-à-dire la mise maximale qu'il peut mettre en jeu pour que l'espérance de gain reste positive. Dans ce jeu pour gagner il faut faire fois Pile avant de faire Face, la probabilité de gagner € est donc de . Ainsi l'espérance de gain de ce jeu, sans prendre en compte la mise, est de :

.

On en conclu qu'un décideur qui se fie à l'espérance de gain pour prendre ses décisions sera prêt à payer n'importe quelle mise pour pouvoir jouer à ce jeu, puisque son espérance de gain restera infinie quelle que soit sa mise de départ. Pourtant aucun décideur raisonnable ne serait prêt à miser plus de quelques euros pour jouer à ce jeu.

Daniel Bernoulli résout ce paradoxe en introduisant l'hypothèse selon laquelle les individus ne maximisent pas l'espérance de gain mais une espérance morale :

où est une fonction logarithmique. Pour Bernoulli, la valeur subjective d'un jeu n'augmente pas linéairement avec la valeur monétaire de la récompense, mais avec un taux décroissant. Sous une telle hypothèse de la non-linéarité du traitement des conséquences d'une loterie par le décideur, le paradoxe de Saint-Pétersbourg est complètement résolu. La fonction est appelée fonction d'utilité. Ce sont ces travaux qui ont inspiré la théorie de l'utilité espérée proposée par John von Neumann et Oskar Morgenstern.

Théorie de l'utilité espérée et modèle EU[9]

La théorie de l'utilité espérée (aussi appelée théorie EU, de l'anglais « expected utility ») est une théorie de la décision en environnement risqué développée par John von Neumann et Oskar Morgenstern dans leur ouvrage Theory of Games and Economic Behavior (1944). Dans l'optique de fournir une théorie solide sur la modélisation des préférences d'un décideur en situation risquée, von Neuman et Morgenstern généralisent le modèle de Bernoulli fondé sur l'usage d'une fonction d'utilité. Ils montrent, après avoir définit un ensemble d'axiomes sur les préférences d'un décideur, qu'il est toujours possible de construire une fonction d'utilité sur les conséquences d'une loterie, de manière à ce que l'espérance de ces utilités sur les loteries conserve l'ordre de préférence entre les loteries du décideur. La fonction d'utilité construire est alors unique à une transformation affine croissante près. En d'autres termes, si la fonction modélise les préférences du décideur, alors il en est de même pour la fonction si et seulement si avec un réel strictement positif et un réel quelconque. Le modèle de l'espérance d'utilité, sous de tels hypothèses revient alors à calculer l'espérance d'utilité de la loterie :

où est la fonction d'utilité construite via la théorie de l'utilité espérée. En 1953, Maurice Allais propose un paradoxe remettant en cause la capacité à décrire les comportements des décideurs, en illustrant la non validité de l'axiome d'indépendance posé par von Neumann et Morgenstern.

Le paradoxe d'Allais[10],[11]

Le contenu descriptif du modèle de décision EU a été rapidement critiqué dans une expérience restée célèbre sous le nom de « paradoxe d'Allais ». La version présentée ici est celle de Kahneman et Tversky. Les sujets doivent choisir entre deux paires de loteries. D'une part, entre et et, d'autre part, entre et . Dans la première situation de choix, la grande majorité des décideurs soumises à cette expérience préfèrent la loterie à la loterie (ils préfèrent être surs de gagner 3 000 € que de risque de ne rien gagner, un tien vaut mieux que deux tu l'auras). Dans la seconde situation de choix, la majorité des décideurs préfèrent la loterie à la loterie (car la probabilité de gagner 4 000 € dans la loterie et presque la même que celle de gagner 3 000 € dans la loterie ). Si on traduit ce préférences dans le cadre du modèle EU, on obtient alors :

Ainsi, quelle que soit la fonction d'utilité utilisée, la préférence pour sur est équivalente à la préférence pour sur . Ce qui est incompatible avec les résultats de l'expérience menée par Maurice Allais. Allais qualifie ce comportement, loin d'être paradoxal, comme un comportement raisonnable de préférence for security in the neighbourhood of certainty. Ce phénomène est connu sous le nom de l'effet de certitude. Ce phénomène est aujourd'hui bien connu sous le nom de l'effet de certitude . Le renversement de préférences s'explique ici simplement par l'attraction forte du passage de la quasi-certitude à la certitude, et à l'indifférence du passage du peu probable au un peu plus probable. À cela s'ajoute un phénomène de sur-pondération des résultats qui sont certains par rapport aux résultats qui ne sont que probables.[12]

De nombreux autres exemples et critiques ont été formulés dans la littérature économique à l'encontre du modèle EU et la plupart s'accordent à dire que l'axiome d'indépendance est une hypothèse bien trop forte comme le montre le paradoxe d'Allais. Gayant qualifie même de paradoxal le fait de modéliser l'aversion au risque d'un décideur en se fondant sur une fonction portant uniquement sur les conséquences (sans la prise en compte d'éléments probabilistes). Au début du millénaire, Rabin énonce son théorème d'impossibilité sur le critère EU : l'impossibilité de traduire une aversion pour le risque lorsque les enjeux sont faibles dans le cadre du modèle EU[13]. En effet, la concavité de la fonction d'utilité permet d'expliquer l'aversion au risque lorsque les enjeux sont très importants mais implique également une quasi-neutralité vis-à-vis du risque lorsque les enjeux sont plus faibles[14]. En plus de rendre abusivement élevée l'aversion pour le risque lorsque les enjeux sont importants, de nombreuses expériences ont montré l'existence d'une aversion au risque sur les petits enjeux. L'existence d'une aversion pour les petits enjeux met alors en échec la

capacité du modèle EU à décrire l'aversion pour le risque. La solution suggérée pour sortir de ce théorème d'impossibilité est de décharger la fonction d'utilité pour qu'elle ne décrive plus l'aversion au risque mais se contente uniquement de son rôle premier de traduire le degré d'importance d'une conséquence pour le décideur. C'est ce que se propose de faire les modèles dit non-EU.

Modèles non-EU

Dans la multitude de propositions de modèles non-EU qu'aura connu le XXe siècle, certains ont marqué la communauté scientifique. C'est notamment le cas du modèle de l'utilité espérée généralisée proposé par Machina[15]. Ce dernier part du principe que le respect de l'axiome d'indépendance n'est pas une condition nécessaire pour préserver l'hypothèse de maximisation de l'utilité espérée. Ainsi, ce modèle rejette totalement l'axiome d'indépendance et pose des conditions analytiques sur les préférences. Si ce modèle résout quelques situations qui mettaient dans l'impasse le modèle EU, il reste encore trop proche du modèle EU et de légères modifications des paradoxes classiques (comme le paradoxe d'Allais) les font redevenir insolubles.

D'autres propositions de modèles se sont focalisées sur un affaiblissement de l'axiome d'indépendance. Ces modèles dits de betweenness restent néanmoins dans l'impasse dans des situations similaires au paradoxe d'Allais.

Enfin une autre famille de modèles reposant sur une restriction de l'axiome d'indépendance ont permis d'établir des modèles ayant un fort pouvoir descriptif des décideurs et pouvant résoudre n'importe quel paradoxe connu. Ces modèles sont dits à dépendance des rangs. Le plus connu et le plus utilisé étant celui de l'utilité espérée dépendant du rang (Rank Dependent Utility, RDU) proposé par Quiggin[16].

Le tableau ci-dessous propose une synthèse des principaux modèles non-EU dans la littérature.

| Modèles de décision | |

|---|---|

| Rejet de l'axiome d'indépendance | - Utilité espérée généralisée (Machina, 1982)[15] |

| Affaiblissement de l'axiome d'indépendance | - Utilité pondérée (Chew et McCrimmon, 1979)[17]

- Théorie de l'utilité SSB (Fishburn, 1982)[18] - Utilité pondérée implicite (Chew, 1989)[19] - Théorie de la déception (Gul, 1991)[20] |

| Restriction de l'axiome d'indépendance | - Utilité espérée dépendant du rang, RDU (Quiggin, 1982)[16]

- Théorie duale, DT (Yaari, 1987)[21] - Modèle de Allais (Allais, 1988)[22] - Théorie des prospects cumulés, CPT (Tversky et Kahneman, 1992)[23] |

Du modèle EU au modèle RDU

Buffon a proposé une seconde façon de résoudre le paradoxe de Saint-Pétersbourg, par l'introduction de l'hypothèse que les décideurs négligent les petites probabilités et considèrent comme impossible une succession de plus de Piles à la suite. Le décideur se refuse alors à payer une mise supérieure à €. C'est justement cette idée qui a inspiré les modèles à transformation des probabilités. Cette idée de traiter non linéairement les probabilités est la vision duale du traitement non linéaire des conséquences. Handa propose une solution qui ajoute au modèle EU une fonction croissante telle que et qui permet de déformer les probabilités en accord avec les préférences du décideur[24]. En d'autre terme l'évaluation d'une loterie par ce critère vaut:

)

Si l'idée semble séduisante, elle est rapidement abandonnée, car ce modèle peut conduire à prendre des choix non rationnels[18].

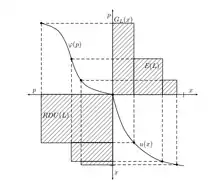

En théorie de la décision dans le risque, on considère que la préférence de la loterie et est rationnelle si où est la dominance stochastique du premier ordre définie par:

si et seulement si et où représente la fonction décumulative de la loterie .

Modèle RDU[16]

L'idée de déformer les probabilités aurait pu sombrer dans l'oubli si Quiggin n'avait pas eu l'idée clef de transformer non pas des probabilités mais des cumuls de probabilités afin d'écarter toute violation de la dominance stochastique du premier ordre par le décideur. La seconde idée clef de ce modèle repose sur l'hypothèse de dépendance du rang : le poids attribué à une conséquence ne dépend pas uniquement de la probabilité d'obtenir cette conséquence, mais également de l'attractivité du rang du rang de cette dernière par rapport aux autres conséquences possibles. Le modèle RDU propose d'évaluer une loterie telle que comme suit:

Le pouvoir descriptif du modèle RDU et sa capacité à conserver une rationalité de choix en fait un des modèles les plus utilisés en représentation des préférences d'un décideur dans le risque.

Théorie de la Décision dans l'incertain non risqué

Dans la pratique, il existe de nombreux problèmes pour lesquels on ne possède pas les distributions de probabilité objectives sur les états de la nature. C'est précisément le cadre de la décision dans l'incertain non risqué. Pour raisonner dans ce cadre, on peut distinguer deux manières d'appréhender le problème.

La première laisse le soin au décideur d'établir lui-même les distributions de probabilité de manière subjective. Cette façon de faire permet de se placer ensuite dans un cadre identique au risque. En revanche, dans de nombreuses situations, il est compliqué, voire impossible, pour un décideur d'établir des distribution de probabilités subjectives sur la vraisemblance des événements.

La seconde propose de raisonner, à l'aide de divers critères de décision adaptés qui exploite la nature des données que l'on possède sur la vraisemblance des événements. Cette façon de faire permet de rester objectif sur la vraisemblance des événement sans apporter d'informations "erronées" dans la modélisation du problème.

Modèles à probabilités subjectives

Au début des années 1930, Ramsey et de Finetti suggèrent qu'en cas d'absence de distribution de probabilité objective, les décideurs établissent eux-mêmes ces probabilités de manière subjective. Ces probabilités doivent rester positives, additives et l'événement certain doit avoir une probabilité de 1 de se réaliser. Le modèle le plus simple est le modèle de l'espérance subjective (Subjective Expected, SE)[25] proposé par Savage.

Théorie de l'espérance subjective et de l'espérance subjective d'utilité

L'hypothèse faite ici, est que le décideur établit une distribution de probabilité subjective sur les états de la nature et procède à un calcul d'espérance de gain pour évaluer la loterie. En d'autres terme l'évaluation de la loterie vaut :

À l'instar de l'espérance de gain dans le cadre du risque, ce modèle tombe sous le coup du paradoxe de Saint-Pétersbourg. Pour pallier cela, à la suite de la proposition du modèle EU par von Neumann et Morgenstern, Savage propose la généralisation du modèle SE en assignant une fonction d'utilité au décideur et postule que les décideurs évaluent une loterie comme suit:

Ce modèle est connu sous le nom de l'espérance subjective d'utilité (Subjective Expected Utility, SEU). De façon semblable au modèle EU dans le risque, ce modèle repose sur un axiome qui impose un traitement linéaire des probabilités : le principe de la chose sure, qui est le pendant de l'axiome d'indépendance dans le cadre du risque. Malgré l'attrait sur le plan normatif du modèle SEU, Daniel Ellsberg publie les résultats d'une expérience qui met en évidence l'incapacité du modèle SEU à modéliser les comportements dans l'incertain. Cette expérience est connue sous le nom de paradoxe d'Ellsberg.

Paradoxe d'Ellsberg[26]

On place dans une urne opaque 30 boules bleues et 60 boules vertes ou rouges (dans des proportions inconnues). Le nombre de boules vertes réelles est donc inconnu, de même que le nombre de boules rouges. On tire au hasard une boule dans cette urne (on fait l'hypothèse que chaque boule a autant de chance qu'une autre d’être tirée). On propose dans un premier temps, de choisir entre deux jeux:

- Jeu 1 : Si la boule tirée est de couleur bleue, alors vous gagnez 100 €.

- Jeu 2 : Si la boule tirée est de couleur verte, alors vous gagnez 100 €.

Ce qui correspond à choisir entre la loterie et la loterie

Dans un second temps, on propose au joueur de choisir entre deux autres jeux :

- Jeu 3 : Si la boule tirée est de couleur bleue ou rouge, alors vous gagnez 100 €.

- Jeu 4 : Si la boule tirée est de couleur verte ou rouge, alors vous gagnez 100 €.

Ce qui correspond à choisir entre la loterie et la loterie .

Les résultats de l'expérience d'Ellsberg ont montré que la majorité des personnes qui se sont pliées à cette expérience ont préféré le jeu 1 au jeu 2 (i.e., ) et en même temps ont préféré le jeu 4 au jeu 3 (i.e., ). Ces préférences sont en contradictions avec les prescriptions du modèle SEU. En effet, si on note l'événement "la boule tirée est bleue", l'événement "la boule tirée est verte" et l'événement "la boule tirée est rouge", alors les préférences du décideur pour le premier choix s'écrivent :

car la fonction est unique à une transformation affine près (on peut donc supposer que sans perte de généralité). De la même manière, les préférences du décideur pour le second choix s'écrivent :

car la distribution de probabilité est additive (i.e., et ).

Les deux inégalités obtenus sont contradictoires, ce qui rend non modélisables par le modèle SEU les préférences des décideurs soumis à cette expérience.

Le renversement des préférences s'explique ici simplement. Dans les deux choix, on propose au décideur de choisir entre un jeu où les probabilités sont parfaitement définies et un jeu où l'on ne connaît pas les probabilités de manière certaine. Cette expérience met en avant le faire que les décideurs préférent généralement les situations où les probabilités sont parfaitement définies aux situations où les probabilités sont mal connues. Ce trait comportemental est nommé l'aversion à l'ambiguïté.

Afin de résoudre ce paradoxe, il est nécessaire d'établir un modèle qui autorise en même temps la propriété et la propriété . Ce qui est possible dès lors que l'on autorise une propriété de non additivité à la distribution . La problématique rencontrée ici est très similaire à la problématique rencontrée dans le cadre du risque et la solution également très similaire. Schmeidler postule qu'il ne faut pas établir les probabilités subjectives en les définissant uniquement sur les événements simples mais les définir également sur les unions des événements simples. Ce modèle est connu sous le nom de l'espérance d'utilité à la Choquet (Choquet Expected Utility, CEU) et permet de résoudre le paradoxe d'Ellsberg[27].

Théorie de la décision séquentielle dans l'incertain

Une problématique plus large, que l'on rencontre fréquemment dans la pratique, est de considérer des situations dans lesquelles le décideur ne devra non pas prendre une unique décision, mais plusieurs décisions étalées dans le temps (i.e., établir une stratégie ou une politique). Ces problématiques sont appelées problème de décision séquentielle dans l'incertain.

Dans cette famille de problèmes, pour une décision à prendre à la date le décideur peut utiliser toute l'information disponible à cette date. Par exemple s'il réfléchit à la date à ce qu'il fera à la date , il peut envisager de prendre des décisions différentes à la date selon l'information qui sera alors disponible à cette date. En d'autres termes, la décision à prendre à la date est conditionnée par les événements connus à la date . De manière classique on fait l'hypothèse qu'une information connue à la date reste connue aux dates ultérieures. Cette hypothèse entraîne que l'ensemble des événements connus à la date forme une sous-partition de l'ensemble des événements connus à la date .

Dans un tel cadre on peut formaliser un problème de décision séquentielle dans l'incertain comme suit. L'ensemble des événements est constitué d'une suite de partitions avec de l'événement certain , étant une sous-partition de pour tout . Une stratégie est constituée par la donnée, pour chaque , d'une décision conditionnelle pour chaque événement , ainsi que d'une décision initiale à .

Au terme de la résolution des différents événements et des décision prises conditionnellement à ces événements, le décideur atteint une conséquence ( désignant l'ensemble de conséquences possibles). Puisque l'on dispose d'une structure emboîtée sur l'ensemble des événements , il suffit de préciser l'événement réalisé à la date pour déterminer les événements qui se sont réalisés aux dates précédentes (par la condition reliant les événements réalisés. Les événements de peuvent alors être considérés comme des événements élémentaires). On utilise alors une fonction résultat qui, à toute suite de décisions () et tout événement , associe où est la conséquence atteinte lorsque se réalise et la suite de décision conditionnelles est prise (où est la décision conditionnelle à l'événement ).

Il apparaît alors que la stratégie peut conduire à autant de conséquences différentes qu'il y a d'événements dans .

Arbre de décision

Il est commode de représenter de manière graphique un problème de décision séquentielle dans l'incertain. Un modèle graphique très utilisée dans la littérature est celui des arbres de décision[28],[29], qui permettent une représentation simple et explicite du problème.

Un graphe orienté est composé d'un ensemble fini de nœuds et d'un ensemble fini d'arcs. Un arc est un couple de nœuds tel que . Si , on dit alors que le nœud est le père du nœud et que le nœud est le fils du nœud .

Un chemin allant du nœud au nœud est un ensemble d'arcs où et . La longueur du chemin est donnée par le nombre d'arcs de .

Le sous-graphe de , induit par l'ensemble de nœuds , est le graphe où .

Un arbre est un graphe orienté dans lequel il existe exactement un nœud, que l'on appelle racine, à partir duquel il existe exactement un chemin allant à chaque nœud. Dans un arbre, s'il existe un chemin allant de à , on dit que le nœud est un ancêtre du nœud et on dit que est un descendant du nœud . Enfin on note la racine d'un arbre. On appelle profondeur ou hauteur d'un arbre la longueur du chemin le plus long depuis la racine vers une feuille.

Le sous-arbre de , est l'arbre de racine qui est le sous-graphe de l'arbre induit par le nœud et les descendants de dans l'arbre .

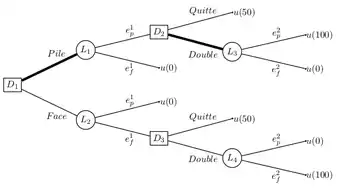

Un arbre de décision est un arbre dont l'ensemble des nœuds est partitionné en trois sous-ensembles disjoints :

- : l'ensemble des nœuds de décision, que l'on représente graphiquement pas des rectangles. Ils représentent les états où le décideur est amené à prendre une décision. Les arcs issus d'un nœud de décision représentent les décisions que peur prendre le décideur en ce nœud.

- : l'ensemble des nœuds de chance, que l'on représente graphiquement par des cercles. Ils représentent les états où la nature intervient (autrement dit, les incertitudes du problème). Les arcs issus d'un nœud de chance représentent les différents événement qui peuvent se réaliser à l’issue de ce nœud.

- : l'ensemble des nœuds terminaux (ou conséquences), qui sont les feuilles de l'arbre (i.e., nœuds n'ayant pas de fils). ils représentent les états terminaux d'un problème de décision séquentielle. Une valeur d'utilité est associée à chaque nœud , correspondant à l'utilité de la conséquence représentée par le nœud .

Arbre de décision représentant un problème de décision séquentielle dans l'incertain. La stratégie {(D1, L1), (D2, L3)} est représentée en gras.

Arbre de décision représentant un problème de décision séquentielle dans l'incertain. La stratégie {(D1, L1), (D2, L3)} est représentée en gras.

Sans perte de généralité on impose que la racine de l'arbre est toujours un nœud de décision. Une stratégie pour un arbre de décision est un ensemble d'arcs où et est un ensemble de nœuds qui contient:

- la racine

- un fils exactement pour chaque nœud

- tous les fils pour chaque nœud

La restriction d'une stratégie à un sous-arbre, qui est une stratégie dans ce sous-arbre, est appelée une sous-stratégie.

Généralement, un tel arbre est représenté horizontalement de manière à ce que les différents nœuds suivent l'ordre chronologique depuis la gauche vers la droite. Notons également que, dans la pratique, on omet de préciser l'orientation des arcs lorsque l'on représente graphiquement un arbre de décision, l'orientation se déduisant naturellement à partir de l'ordre chronologique.

Comparaison de stratégies

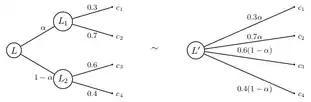

Un décideur soumis à un problème de décision séquentielle dans l'incertain est alors amené à choisir entre différentes stratégies. Pour ce faire, la théorie de la décision se propose de réduire les stratégies à des loteries. Pour cela elle fait l'hypothèse de l'axiome de réduction des loteries composées (ou encore appelé axiome de neutralité).

Axiome de réduction des loteries composées (RLC)

Soit un ensemble de conséquences non vide, et une loi de probabilité sur telle que . L'ensemble des loteries à support dans est un ensemble convexe. C'est-à-dire que :

Cette propriété de mixage peut être vue comme un composition de loterie[30]. La loterie correspond à la loterie à deux étapes qui, dans un premier temps, offre les loteries et avec les probabilités et respectivement et, à la seconde étape, offre la conséquence . Cet axiome considère comme équivalent la loterie composée (à plusieurs étape) et sa forme réduite (à une étape).

Évaluation d'une stratégie

À partir d'une stratégie on peut élaguer tous les sous-arbres descendants des arcs issus des nœuds de décision n'appartenant pas à la stratégie . L'arbre obtenu ne contient que des nœuds de décision ayant un unique fils. Ces derniers peuvent être supprimés en rattachant ce fils à leur père. Les nœuds restants forment une loterie composée. La loterie composée obtenue peut être réduite via la RLC. La loterie résultante peut enfin s'évaluer avec n'importe quel critère issu de la théorie de la décision dans l'incertain.

Un critère de décision s'applique dans la littérature indifféremment sur une loterie ou sur une stratégie dès lors que la RLC est supposée. Un décideur préfère la stratégie à la stratégie au sens du critère de décision si et seulement si .

Recherche d'une stratégie optimale

Le nombre de stratégie possibles dans un arbre de décision peut être de taille exponentielle en la t'aille de l'arbre[31]. Face à ce constat il n'est pas envisageable d'énumérer l'ensemble des stratégies pour les évaluer une à une afin de sélectionner celle maximisant le critère de décision donné. La recherche d'une stratégie optimale, au sens d'un critère de décision donné, est un problème algorithmique qui peut s'avérer compliqué.

Recherche d'une stratégie optimale pour le modèle EU

Dans le cadre du modèle EU, la recherche de la stratégie optimale peut s'obtenir par un algorithme de programmation dynamique, dont le principe est de construire la stratégie optimale en remontant, par induction arrière dans l'arbre de décision, la meilleure stratégie de chaque sous-arbre. L'algorithme permettant de remonter la stratégie optimale et sa valeur au sens du modèle EU est le suivant :

ProgDyn(nœud ): si alors: retouner () si alors: s_opt, v_max := (, ) pour chaque nœud fils de : s_tmp, v_tmp := ProgDyn() si v_tmp > v_max alors: s_opt, v_max := s_tmp, v_tmp retourner (s_opt, v_max) si alors: s_opt, v_max := (, 0) pour chaque nœud fils de : s_tmp, v_tmp := ProgDyn() s_opt, v_max := (s_opt s_tmp, v_max + v_tmp) retourner (s_opt, v_max)

La validité de cet algorithme par programmation dynamique repose sur le respect de la propriété de monotonie (qui est un affaiblissement du principe de Bellman)[32]. On dit qu'un critère de décision respecte la propriété de monotonie si et seulement si :

et on a

Dans le cadre du risque cette propriété est vérifiée dès lors que l'axiome d'indépendance est respecté par le critère . Cet axiome rend possible toute approche par programmation dynamique pour déterminer une stratégie optimale au sens de .

Recherche d'une stratégie optimale pour les modèles non-EU

Les critères non-EU ne sont généralement pas compatibles avec l'axiome d'indépendance. Il est rare alors de pouvoir appliquer une approche par induction arrière pour déterminer une stratégie optimale. Pire, la stratégie construite ainsi peut être dominée stochastiquement au premier ordre par une autre stratégie disponible[29],[33]. Dans le cadre du modèle RDU, le problème est même NP-difficile et il faut alors utiliser des algorithmes d'optimisation combinatoire pour déterminer la stratégie optimale vue de la racine de l'arbre[31]. Ces approches algorithmiques sont du ressort de la théorie de la décision algorithmique.

Cohérence dynamique et conséquentialisme

L'échec de la programmation dynamique pour la détermination d'une stratégie optimale est souvent révélateur de certaines propriété normatives qui sont violées par le critère. La violation de ces propriétés a fait couler beaucoup d'encre et a relancer le débat sur la légitimité de l'axiome d'indépendance. Les arguments exposés ont fait l'objet d'une littérature conséquente mais assez disparate dans le sens où les différences terminologiques et conceptuelles d'un auteur à l'autre rendent très difficile la lisibilité[34]. Ainsi, il en est ressorti que le rejet de l'axiome d'indépendance pose des difficultés normatives dans un cadre de décision séquentielle. En effet, en décision séquentielle, un axiome qui se pose naturellement est celui de la cohérence dynamique. Cet axiome stipule que les préférences d'un décideur sont identiques à tout instant. Ainsi, un décideur est dit cohérent dynamiquement s'il est cohérent dans le temps et ne change pas d'avis alors que l'ensemble de l'information reste inchangée (car la résolution de l'incertitude est prise en compte ex-ante dans la détermination de la stratégie optimale).

Il est démontré que l'axiome de cohérence dynamique est vérifié si l'axiome d'indépendance est vérifié[35],[36]. Dans la théorie du conséquentialisme, l'axiome d'indépendance découle de trois axiomes de rationalité dynamique : l'axiome de cohérence dynamique, l'axiome conséquentialiste et l'axiome de réduction des loteries composées. L'axiome de cohérence dynamique est une propriété normative fortement désiré dans la rationalité du décideur. L'axiome de réduction de loterie a été très peu étudié dans la littérature, peu ou pas de pistes ne remettent en cause son utilisation (mais la perte de l'ordre d’exécution des événements lors de la réduction est un sujet qui a été pointé méritant d'être approfondi[6]) . Cependant le rejet de l'axiome conséquentialiste semble naturel dans plusieurs situations de choix[37], et il est démontré que le rejet de l'axiome conséquentialiste ne remet pas en cause la validité de l'axiome de cohérence dynamique[38]. La différence entre un décideur qui adopte un comportement conséquentialiste et un décideur qui adopte un comportement non-conséquentialiste, vient du fait que le décideur accorde encore de l'importance à un risque déjà encouru contrairement au décideur qui ne tient plus compte d'un risque une fois qu'il a été encouru. Le comportement d'un décideur cohérent dynamiquement et non-conséquentialiste est connu dans la littérature sous le nom de choix résolu. Le choix résolu désigne le comportement d'un décideur qui se fixe un plan de décision et n'en dévie plus par la suite (i.e., qui s'impose de rester cohérent dynamiquement).

Les approches algorithmiques mettant en œuvre le choix résolu pour des critères rejetant l'axiome conséquentialiste ont été proposées dans la littérature sous le nom de veto-process[39].

Voir aussi

Articles connexes

Références

- Cet article est partiellement ou en totalité issu de l'article intitulé « Théorie de la décision » (voir la liste des auteurs).

- Didier DUBOIS, « La théorie des possibilités », Revue de l'Electricité et de l'Electronique, no 07, , p. 42 (ISSN 1265-6534, DOI 10.3845/ree.2006.059, lire en ligne, consulté le )

- (en) Didier Dubois, Hélène Fargier et Patrice Perny, « Qualitative decision theory with preference relations and comparative uncertainty: An axiomatic approach », Artificial Intelligence, vol. 148, nos 1-2, , p. 219–260 (ISSN 0004-3702, DOI 10.1016/s0004-3702(03)00037-7, lire en ligne, consulté le )

- Shafer, Glenn, 1946-, A mathematical theory of evidence, Princeton University Press, (ISBN 978-0-691-21469-6, 0-691-21469-7 et 978-0-691-08175-5, OCLC 1150279856, lire en ligne)

- Karl Borch et Howard Raiffa, « Decision Analysis: Introductory Lectures on Choices under Uncertainty », Econometrica, vol. 39, no 1, , p. 194 (ISSN 0012-9682, DOI 10.2307/1909156, lire en ligne, consulté le )

- « Risque et décision (Economie) GAYANT Jean-Pascal », sur Librairie Lavoisier (consulté le )

- Gildas Jeantet, « Algorithmes pour la décision séquentielle dans l'incertain : optimisation de l'utilité espérée dépendant du rang et du critère de Hurwicz », Thesis, UPMC, (lire en ligne, consulté le )

- (en) Victor S. Thomas Professor of Psychology R. Duncan Luce, R. Duncan Luce et Howard Raiffa, Games and Decisions: Introduction and Critical Survey, Dover Publications, (ISBN 978-0-486-65943-5, lire en ligne)

- Jean-Yves Jaffray, « Rational decision making with imprecise probabilities », ISIPTA '99 - 1st International Symposium on Imprecise Probabilities and Their Applications, Université de Gand, , p. 183–188 (lire en ligne, consulté le )

- (en) John Von Neumann et Oskar Morgenstern, Theory of games and economic behavior, (OCLC 1629708, lire en ligne)

- (en) Daniel Kahneman et Amos Tversky, « Prospect theory: an analysis of decision under risk », Foundations of probability, econometrics and economic games / edited by Omar F. Hamouda and J.C.R. Rowley, (lire en ligne, consulté le )

- M. Allais, « Le Comportement de l'Homme Rationnel devant le Risque: Critique des Postulats et Axiomes de l'Ecole Americaine », Econometrica, vol. 21, no 4, , p. 503 (ISSN 0012-9682, DOI 10.2307/1907921, lire en ligne, consulté le )

- (en) Chris Starmer, « Developments in Non-expected Utility Theory: The Hunt for a Descriptive Theory of Choice under Risk », Journal of Economic Literature, vol. 38, no 2, , p. 332–382 (ISSN 0022-0515, DOI 10.1257/jel.38.2.332, lire en ligne, consulté le )

- Matthew Rabin, « Risk Aversion and Expected-Utility Theory: A Calibration Theorem », Econometrica, vol. 68, no 5, , p. 1281–1292 (ISSN 0012-9682, lire en ligne, consulté le )

- Stephen J. Turnovsky, « Essays in the Theory of Risk-Bearing. Kenneth J. Arrow », Journal of Political Economy, vol. 80, no 6, , p. 1328–1329 (ISSN 0022-3808, DOI 10.1086/259978, lire en ligne, consulté le )

- Mark J. Machina, « "Expected Utility" Analysis without the Independence Axiom », Econometrica, vol. 50, no 2, , p. 277–323 (ISSN 0012-9682, DOI 10.2307/1912631, lire en ligne, consulté le )

- (en) John Quiggin, « A theory of anticipated utility », Journal of Economic Behavior & Organization, vol. 3, no 4, , p. 323–343 (ISSN 0167-2681, DOI 10.1016/0167-2681(82)90008-7, lire en ligne, consulté le )

- (en) S. M. Chew, Alpha-nu Choice Theory: A Generalization of Expected Utility Theory, British Columbia, (lire en ligne)

- (en) P. C Fishburn, « Dominance in SSB utility theory », Journal of Economic Theory, vol. 34, no 1, , p. 130–148 (ISSN 0022-0531, DOI 10.1016/0022-0531(84)90165-0, lire en ligne, consulté le )

- (en) Soo Hong Chew, « Axiomatic Utility Theories with the Betweenness Property », sur repository.ust.hk, (consulté le )

- Faruk Gul, « A Theory of Disappointment Aversion », Econometrica, vol. 59, no 3, , p. 667–686 (ISSN 0012-9682, DOI 10.2307/2938223, lire en ligne, consulté le )

- Menahem E. Yaari, « The Dual Theory of Choice under Risk », Econometrica, vol. 55, no 1, , p. 95–115 (ISSN 0012-9682, DOI 10.2307/1911158, lire en ligne, consulté le )

- (en) Maurice Allais, « The General Theory of Random Choices in Relation to the Invariant Cardinal Utility Function and the Specific Probability Function. The (U, θ) Model A General Overview », dans Risk, Decision and Rationality, Springer Netherlands, coll. « Theory and Decision Library », (ISBN 978-94-009-4019-2, DOI 10.1007/978-94-009-4019-2_16, lire en ligne), p. 231–289

- AMOS TVERSKY et DANIEL KAHNEMAN, « Advances in Prospect Theory: Cumulative Representation of Uncertainty », Journal of Risk and Uncertainty, vol. 5, no 4, , p. 297–323 (ISSN 0895-5646, lire en ligne, consulté le )

- Jagdish Handa, « Risk, Probabilities, and a New Theory of Cardinal Utility », Journal of Political Economy, vol. 85, no 1, , p. 97–122 (ISSN 0022-3808, lire en ligne, consulté le )

- Bruno de Finetti, « La prévision : ses lois logiques, ses sources subjectives », Annales de l'institut Henri Poincaré, vol. 7, no 1, , p. 1–68 (lire en ligne, consulté le )

- Daniel Ellsberg, « Risk, Ambiguity, and the Savage Axioms », The Quarterly Journal of Economics, vol. 75, no 4, , p. 643–669 (ISSN 0033-5533, DOI 10.2307/1884324, lire en ligne, consulté le )

- « Integral Representation Without Additivity | Institute for Mathematics and its Applications », sur www.ima.umn.edu (consulté le )

- (en) Howard Raiffa, Decision analysis: introductory lectures on choices under uncertainty, (ISBN 978-0-201-06290-8 et 978-0-201-05750-8, OCLC 449943, lire en ligne)

- (en) Thomas D. Nielsen et Jean-Yves Jaffray, « An operational approach to rational decision making based on rank dependent utility », (consulté le )

- (en) Edi Karni et David Schmeidler, « Chapter 33 Utility theory with uncertainty », dans Handbook of Mathematical Economics, vol. 4, Elsevier, (lire en ligne), p. 1763–1831

- (en) Gildas Jeantet et Olivier Spanjaard, « Computing rank dependent utility in graphical models for sequential decision problems », Artificial Intelligence, representing, Processing, and Learning Preferences: Theoretical and Practical Challenges, vol. 175, no 7, , p. 1366–1389 (ISSN 0004-3702, DOI 10.1016/j.artint.2010.11.019, lire en ligne, consulté le )

- (en) Thomas L Morin, « Monotonicity and the principle of optimality », Journal of Mathematical Analysis and Applications, vol. 88, no 2, , p. 665–674 (ISSN 0022-247X, DOI 10.1016/0022-247X(82)90223-2, lire en ligne, consulté le )

- Gildas Jeantet, « Optimisation du critère d'Hurwicz pour les arbres de décision hasard en situation d'incertain total », 7ème Manifestation de JEunes Chercheurs STIC (MAJECSTIC'09), (lire en ligne, consulté le )

- (en) Nathalie Etchart-Vincent, « Adequate Moods for non-EU Decision Making in a Sequential Framework », Theory and Decision, vol. 52, , p. 1 (DOI 10.1023/A:1015503119317, lire en ligne, consulté le )

- Peter J. Hammond, « Consequentialist Foundations for Expected Utility », Theory and Decision, vol. 25, no 1, , p. 25–78 (DOI 10.1007/bf00129168, lire en ligne, consulté le )

- Peter J. Hammond, « Consistent Plans, Consequentialism, and Expected Utility », Econometrica, vol. 57, no 6, , p. 1445–1449 (ISSN 0012-9682, DOI 10.2307/1913716, lire en ligne, consulté le )

- Mark J. Machina, « Dynamic Consistency and Non-Expected Utility Models of Choice Under Uncertainty », Journal of Economic Literature, vol. 27, no 4, , p. 1622–1668 (ISSN 0022-0515, lire en ligne, consulté le )

- Edward F. McClennen, Rationality and Dynamic Choice: Foundational Explorations, Cambridge University Press, (lire en ligne)

- Jean-Yves Jaffray, « Implementing resolute choice under uncertainty », UAI'98 - 14th conference on Uncertainty in AI 98, Morgan Kaufmann, San Francisco, , p. 282–288 (lire en ligne, consulté le )

- Portail des mathématiques

- Portail de l'informatique théorique

- Portail des probabilités et de la statistique

- Portail de l’économie

- Portail de la sociologie