Allocation de Dirichlet latente

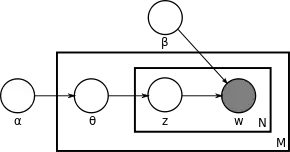

Dans le domaine du traitement automatique des langues, l’allocation de Dirichlet latente (de l’anglais Latent Dirichlet Allocation) ou LDA est un modèle génératif probabiliste permettant d’expliquer des ensembles d’observations, par le moyen de groupes non observés, eux-mêmes définis par des similarités de données.

Thèmes en LDA

Par exemple, si les observations () sont les mots collectés dans un ensemble de documents textuels (), le modèle LDA suppose que chaque document () est un mélange () d’un petit nombre de sujets ou thèmes ( topics), et que la génération de chaque occurrence d’un mot () est attribuable (probabilité) à l’un des thèmes () du document. Le modèle LDA est un exemple de « modèle de sujet » . Il a d'abord été présenté comme un modèle graphique pour la détection de thématiques d’un document, par David Blei, Andrew Ng et Michael Jordan en [1]. Les applications de la LDA sont nombreuses, notamment en fouille de données et en traitement automatique des langues.

Fonctionnement

On fixe un nombre K de thèmes et on cherche à apprendre les thèmes représentés dans chaque document et les mots associés à ces thèmes.

Initialisation

On attribue un thème à chaque mot de chaque document, selon une distribution de Dirichlet sur un ensemble de K thèmes.

, avec et est une distribution de Dirichlet avec un paramètre symétrique creux ()

Ceci génère un premier « modèle de sujet » : des thèmes présents dans les documents et les mots définissant les thèmes. Ce modèle de sujet est très peu vraisemblable car généré aléatoirement.

Apprentissage

On cherche à améliorer le modèle de sujet généré aléatoirement en initialisation. Pour cela, dans chaque document, on prend chaque mot et on met à jour le thème auquel il est lié. Ce nouveau thème est celui qui aurait la plus forte probabilité de le générer dans ce document. On fait donc l’hypothèse que tous les thèmes sont corrects, sauf pour le mot en question.

Plus précisément : pour chaque mot () de chaque document (), on calcule deux quantités pour chaque thème () :

- : la probabilité que le document soit assigné au thème

- : la probabilité que le thème dans le corpus soit assigné au mot

On choisit alors le nouveau thème t avec la probabilité . Ceci correspond à la probabilité que le thème génère le mot dans le document .

En répétant les étapes précédentes un grand nombre de fois, les assignations se stabilisent. On obtient le mélange de thème présent dans chaque document en comptant chaque représentation d’un thème (assigné aux mots du document). On obtient les mots associés à chaque thème en comptant les mots qui y sont associés dans le corpus.

Notes et références

- David Blei, Andrew Ng et Michael I. Jordan, « Latent Dirichlet Allocation », Proceedings of the 14th International Conference on Neural Information Processing Systems: Natural and Synthetic, Vancouver, British Columbia, Canada, MIT Press, no NIPS’01, , p. 601-608 (lire en ligne, consulté le )

Bibliographie

- (en) David M. Blei, Andrew Y. Ng et Michael I. Jordan, « Latent dirichlet allocation », Journal of machine Learning research, John Lafferty, vol. 3, , p. 993-1022 (lire en ligne, consulté le )

- (en) Thomas L. Griffiths, Mark Steyvers, David M. Blei et Joshua B. Tenenbaum, « Integrating Topics and Syntax », Advances in Neural Information Processing Systems 17, L. K. Saul and Y. Weiss and L. Bottou, , p. 537-544 (lire en ligne, consulté le )

Voir aussi

Articles connexes

Liens externes

- (en) Kevin R. Canini, Lei Shi et Thomas Griffiths, « Online Inference of Topics with Latent Dirichlet Allocation », Proceedings of the Twelth International Conference on Artificial Intelligence and Statistics, PMLR « Proceedings of Machine Learning Research », , p. 65-72 (lire en ligne)

- Portail des probabilités et de la statistique

- Portail de l’informatique