Avant d’aborder le cœur des fonctionnalités du logiciel, nous allons tout d’abord définir les qualifications Open Source de Talend. Par la suite, nous allons spécifier de manière explicite d’une part la création historique de Talend, et d'autres part la déclinaison des fonctions de Talend

Définition Open Source

La désignation open source (en français « source ouverte » ou « code source libre ») s'applique aux œuvres ou aux logiciels dont la licence respecte des critères précis :

- La possibilité de libre redistribution

- La liberté d'accès au code source

- L’autorisation de travaux dérivés

- L’autorisation de publication des travaux dérivés

- La recette d'un gâteau au chocolat

- Le plan de montage d'un ordinateur

- Le code source du logiciel FIREFOX

- La formule chimique de l'eau

Talend est fourni sous les termes de la Licence Apache, qui elle-même est une licence de logiciel libre et open source. En d'autres termes, les caractéristiques majeures de l'open source Talend sont, d'une part, d'autoriser la modification et la distribution du code sous toute forme (libre ou propriétaire, gratuit ou commercial) et, d’autre part, d'obliger le maintien du copyleft lors de toute modification.

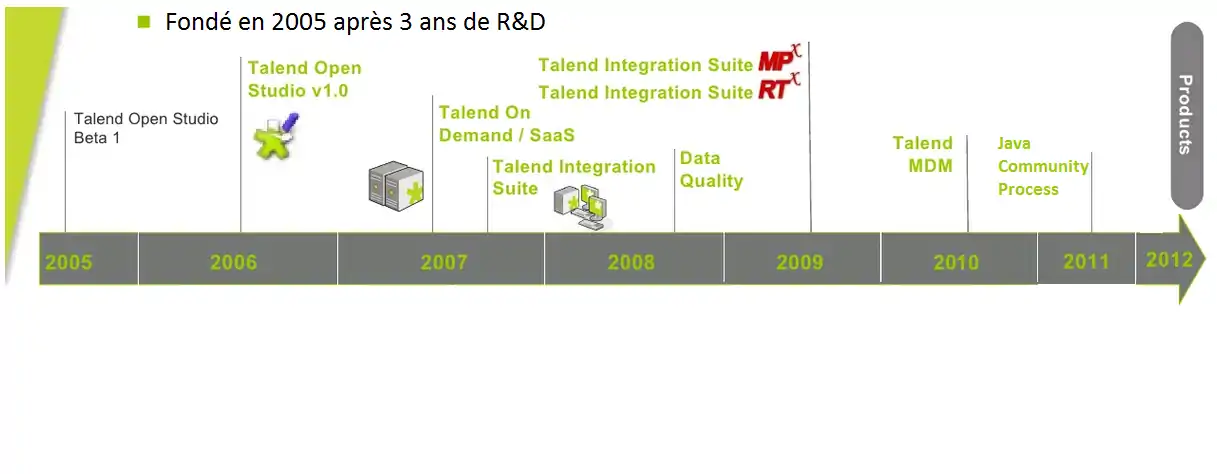

Historique de Talend

L'un des leaders mondiaux du marché naissant du "big data" est français. Créé en 2005 par Bertrand Diard et Fabrice Bonan, Talend compte aujourd’hui 400 collaborateurs dont 120 ingénieurs en France (à Suresnes) pour la partie R&D et 4 000 clients dans le monde. La start-up fournit des solutions d'aide à la gestion et à l'intégration de données.

Enjeux des entreprises

Le fait que les systèmes d’information des entreprises deviennent de plus en plus complexes n’est pas vraiment nouveau :

- Une première raison à cela tient au fait que les entreprises déploient généralement de nouvelles applications tout en maintenant les anciennes solutions (“empilage de couches”)

- En outre les entreprises sont contraintes d’ouvrir de plus en plus leurs systèmes d’information à leurs fournisseurs, leurs partenaires et leurs clients

- Enfin cette complexification s’explique aussi par la multiplication des formats de stockage de données, des protocoles (FTP, HTTP, SOAP, SCP, etc.) et des technologies des bases de données

Une question ressort de ces trois constats :

Comment réussir son intégration de données lorsque celles-ci sont éparpillées dans divers systèmes d’information ?

Les fonctions qui se cachent derrière le principe d’intégration données sont déclinés en deux parties : l’intégration décisionnelle (alimentation d’entrepôts de données) et l’intégration opérationnelle (capture et migration de données, synchronisation de bases de données, échanges inter-applicatifs, etc)

Talend open studio couvre tous ces besoins qu’il s’agisse d’intégration décisionnelle ou opérationnelle.

Talend open studio

Intégration décisionnelle avec Talend open studio

Les processus ETL reprennent les données de tous les systèmes opérationnels et les traitent en amont pour les outils d’analyse et de reporting, Talend Open Studio offre une très grande connectivité aux :

- Progiciels (ERP, CRM, etc.), bases de données, serveurs centraux, fichiers, Web Services, ..., pour couvrir la disparité grandissante des sources

- Entrepôts de données, applications OLAP (Online Analytical Processing) pour analyse, reporting, dashboarding, scorecarding, ...

- Composants ETL avancés stockés dans un réseau local, incluant des manipulations de chaînes,dimensions, traitement automatique des références, support de charges désordonnées, ...

Intégration opérationnelle avec Talend open studio

L’intégration opérationnelle de données est souvent utilisée pour intégrer les programmes et rapports habituels, complétée en fonction des besoins exprimés de l'entreprise. Les applications de chargement/migration de données et de synchronisation/réplication de données sont les plus répandues en matière d’intégration opérationnelle de données. Elles requièrent :

- des mappings et transformations complexes avec fonctions d’agrégation, calculs, etc. pour pallier les différences dans la structure des données

- le traitement et la résolution des conflits de données en tenant compte des mises à jour des enregistrements ou des “propriétaires des enregistrements”

- la synchronisation de données presque en temps réel étant donné que les systèmes impliquent un temps de latence assez lent