Introduction

Dans les cas réels, et notamment en mécanique, il est courant d’avoir affaire à des équations différentielles d'ordre 2 ou plus. Le but de ce chapitre est de montrer comment, grâce à l'algèbre et à la notation matricielle, tout problème d'équation différentielle linéaire ordinaire à coefficients constants peut être ramené au cas « simple » d'une équation différentielle d'ordre un, traité dans le chapitre précédent.

En particulier, cela amène des résultats très généraux, comme l’existence de solutions, ou la dimension de l'espace des solutions, tout en proposant une méthode de résolution efficace.

Objet d'étude

Rappelons l’objet d'étude de ce chapitre :

Soient et C des complexes, an étant non-nul. Soit f une fonction n fois dérivable sur , à valeur dans ou . On appelle équation différentielle linéaire ordinaire d'ordre n (à coefficients constants) la relation :

Puisque cela nous sera utile par la suite, introduisons dès maintenant quelques notations :

Les valeurs propres d'une matrice sont notées . Le vecteur propre assocé à est noté . Le polynôme caractéristique d'une matrice M, défini comme le déterminant de , est noté .

Mise en forme matricielle

Réduction de l’ordre

Grâce à la notation matricielle, nous allons réécrire cette relation sous la forme d'une simple équation du premier ordre. Pour cela, on va augmenter le nombre de dimensions. Nous ne travaillerons alors plus avec des scalaires, mais avec des vecteurs et des matrices.

Il est commode dans un premier temps de ne considérer que le cas homogène. La solution générale s'obtiendra aisément en ajoutant une solution particulière (constante) à la solution homogène. Pour simplifier encore davantage les calculs, divisons tous les coefficients par an (celui-ci étant non-nul) sans changer leur nom. On travaille donc sur l'équation différentielle :

Posons tout d’abord le vecteur X :

Ce vecteur est dérivable, et on a bien sûr :

L'idée est alors de réécrire l'équation différentielle de départ, comme somme de X’ et de X : on aura ainsi une équation différentielle (matricielle) linéaire d'ordre un ! On cherche donc à écrire : Avec M une matrice n × n, dont les coefficients doivent être bien choisis. Tentons de les retrouver.

Travaillons ligne par ligne. La première ligne porte simplement les coefficients -an-1, ..., -a₀ dans cet ordre, de manière triviale. La seconde ligne peut être facilement résolue en mettant un coefficient 1 pour la dérivée (n+1)-ième, et 0 partout ailleurs. Il en est de même pour les autres. Finalement, on obtient :

On peut remarquer le fait que M est une matrice compagnon.

Propriétés de la matrice M

Nous allons notamment nous intéresser aux valeurs et vecteurs propres de M. Le déterminant de cette matrice est le produit de ses valeurs propres, la trace est leur somme. Le déterminant et la trace de M sont respectivement :

Les valeurs propres sont les racines du polynôme caractéristique (au signe près) :

La résolution explicite, pour des équations d'ordre supérieur à 3, est difficile à la main, sauf cas particuliers. Néanmoins, l’utilisation de méthodes heuristiques (pour trouver une racine « triviale ») réduit le degré du problème — et il est toujours envisageable d’utiliser des logiciels de calcul formel (Mathematica, Matlab, Maple…), qui trouveront rapidement les racines.

En fait, M est toujours diagonalisable, que ses valeurs propres soient distinctes (auquel cas on peut diagonaliser M par une matrice de Vandermonde), ou pas. On a donc une matrice inversible P, telle que :

Résolution de l'équation différentielle

Forme de la solution

Repartons de notre équation différentielle matricielle :

Par analogie avec le cas simple décrit dans le chapitre précédent, une solution est de la forme :

La solution à l'équation de départ, non-homogène, s'obtient facilement en rajoutant une constante adaptée.

Mais qu'est-ce qu'une exponentielle de matrices ?

Exponentielle de matrices

Il existe deux manières d'approcher l'exponentielle de matrices, qui sont complémentaires : soit d'un point de vue géométrique, soit d'un point de vue analytique. Nous choisissons ici la première approche, probablement plus simple.

Rappelons tout d’abord une relation très importante :

Soient et . Alors

Dans le cas d'une matrice diagonalisable, il est même possible d'expliciter complètement l'exponentielle de matrice, ce qui nous est fort utile ici. On a, en effet, le théorème suivant :

La méthode alternative, mais qui ne permet pas toujours une résolution manuelle, est d’utiliser la série entière de l'exponentielle :

Puisqu'on est capable de calculer toutes les puissances de M, l’utilisation de cette somme est envisageable. Elle est en réalité plus pratique dans les cas d'évaluation numérique : il n'est plus besoin de considérer les éventuelles valeurs propres ou vecteurs propres de la matrice.

Solution

On obtient, d'un seul coup, la solution pour la fonction f et pour toutes ses dérivées. Faisons rentrer le facteur A de la solution homogène dans l’expression développée de l'exponentielle, et prenons en compte la quantité constante non-homogène. La solution finale à l'équation différentielle ordinaire linéaire à coefficients constants d'ordre n de départ est alors :

Équations à coefficients non-constants

Échec des théorèmes d'ordre un

Le travail effectué jusqu'ici n'est valable que si les coefficients de l'équation différentielle sont des complexes. Peut-on généraliser ces résultats aux cas où il s'agit de fonctions de x ? La réponse, malheureusement, est non. Pire : il est impossible d'exprimer la solution, si solution il y a, par une formule finie (on parle de résolution en forme close). En fait, seules les équations d'ordre un (décrites dans le chapitre 1) et deux (décrites dans le chapitre 5) admettent des solutions analytiques.

En reprenant les notations du paragraphe précédent, l'équation différentielle homogène d'ordre n peut s'écrire sous la forme d'une équation matricielle d'ordre un :

avec l’application matricielle :

Devrons-nous pour autant renoncer à leur résolution ?

Les séries de Magnus

Il existe un moyen de résoudre ces équations : les séries de Magnus. L’idée est que, par analogie avec le cas à coefficients constants, on va chercher X sous la forme d'une exponentielle de matrices :

avec une certaine application matricielle à déterminer.

Cette application est solution de quelques relations, qui permettent de déduire qu'elle peut être définie par une série, appelée série de Magnus :

avec . Il s'agit d'une somme infinie.

Si converge, alors est solution de l'équation différentielle homogène à coefficients constants.

La question est, justement, de savoir quand cette série converge. Cette question n’est pas à l’heure actuelle (2007) complètement résolue. Toutefois, de nombreux résultats existent, parmi lesquels cette condition suffisante (mais pas nécessaire) :

Si , alors converge.

Propriétés

Stabilité analytique

La question de la stabilité, évoquée dans le chapitre précédent pour les équations du premier ordre, est en fait très générale.

Une équation différentielle est dite stable analytiquement lorsque toutes ses solutions éventuelles sont bornées et convergentes. Elle est dite instable dans le cas contraire.

La stabilité d'une équation différentielle linéaire ordinaire est liée aux valeurs propres de la matrice associée :

Une équation différentielle ordinaire linéaire est :

- analytiquement ω-stable si et seulement si, pour toute valeur propre λ, Re(λ) < 0 ;

- analytiquement instable dans le cas contraire ;

- α-instable si et seulement si, il existe une valeur propre λ telle que Re(λ) > 0 ;

Remarques :

- dans le cas d'une équation ω-stable, le polynôme caractéristique du problème est un polynôme d'Hurwitz ;

- dans le cas d'une équation α-instable, il s'agit d'un polynôme de Schur. Les cas α-instables seraient ω-stables si on inversait le sens du temps ;

- ce théorème de stabilité se généralise, moyennant quelques conditions supplémentaires, aux cas d'équations différentielles non-linéaires ;

- le cas où toutes les valeurs propres sont de partie réelle nulle n’est pas analytiquement stable parce que les solutions obtenues oscillent et ne convergent donc pas — elles sont néanmoins bornées, et vérifient une autre forme de stabilité, moins restrictive, appelée « stabilité EBSB » (pour « entrée bornée, sortie bornée »).

Stabilité numérique

Une équation standard pour définir et évaluer la stabilité d'une méthode numérique est , dont la solution analytique est . La méthode d'Euler pour une telle équation donne :

Introduisons une notion au travers de cette méthode, qui est en réalité plus générale, mais n'est ici qu’illustrative.

Ce qui se ramène à , résultat partagé en fait par toutes les méthodes de Runge-Kutta. Posons la fonction , alors .

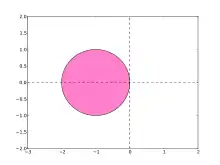

La fonction est appelée fonction de stabilité de la méthode d'Euler. Trivialement, la méthode donne un résultat borné si et seulement si cette fonction est de module inférieur ou égal à 1, et la limite est nulle si et seulement si ce module est inférieur strictement à 1. L'ensemble des complexes pour lesquels cette dernière condition est vérifiée est appelée région de stabilité.

On peut alors donner deux définitions de la stabilité numérique, par ordre croissant d'efficacité (et de rareté) :

- Une méthode d'intégration numérique qui, pour toute équation différentielle convergente, converge également, est dite A-stable.

- Une méthode d'intégration numérique dont la fonction de stabilité tend vers 0 lorsque son argument devient grand en module est dite L-stable.

Alors, on peut discuter de la stabilité d'une méthode, sachant le théorème suivant :

Une méthode d'intégration numérique est A-stable lorsque le demi-plan des complexes de partie négative est compris dans sa région de stabilité.

Pour la méthode d'Euler, la région de stabilité se réduit à un cercle : il ne s'agit donc pas d'une méthode A-stable. Néanmoins, il est toujours possible (lorsque k < 0) de trouver un pas h tel que la fonction de stabilité soit de module inférieur à 1, et donc que l'intégration numérique converge.